使用Apache Geode进行开发

使用Apache Geode进行开发解释了使用Apache Geode进行应用程序编程的主要概念。 它描述了如何规划和实现区域,数据序列化,事件处理,增量传播,事务等。

有关Geode REST应用程序开发的信息,请参阅为Apache Geode开发REST应用程序.

区域数据存储和分发

Apache Geode数据存储和分发模型可以在适当的时间将您的数据放在正确的位置。 在开始配置数据区域之前,您应该了解Geode中数据存储的所有选项。

分区区域

除基本区域管理外,分区区域还包括高可用性选项,数据位置控制以及跨集群的数据平衡。

分布式和复制区域

除基本区域管理外,分布式和复制区域还包括推送和分发模型,全局锁定和区域条目版本等选项,以确保Geode成员之间的一致性。

区域更新的一致性

Geode确保区域的所有副本最终在托管该区域的所有成员和客户端上达到一致状态,包括分发区域事件的Geode成员。

一般地区数据管理

对于所有区域,您可以选择控制内存使用,将数据备份到磁盘,并将过时数据保留在缓存之外。

数据序列化

您在Geode中管理的数据必须序列化和反序列化,以便在进程之间进行存储和传输。 您可以选择多个数据序列化选项。

事件和事件处理

Geode为缓存的数据和系统成员事件提供了通用且可靠的事件分发和处理。

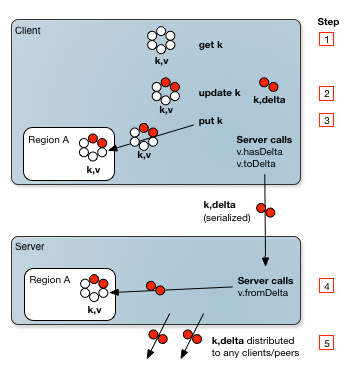

增量传播

增量传播允许您通过仅包括对象而不是整个对象的更改来减少通过网络发送的数据量。

查询

Geode提供了一种类似SQL的查询语言OQL,允许您访问存储在Geode区域中的数据。

连续查询

连续查询会不断返回与您设置的查询匹配的事件。

事务

Geode提供了一个事务API,使用

begin,commit和rollback方法。 这些方法与熟悉的关系数据库事务方法非常相似。函数执行

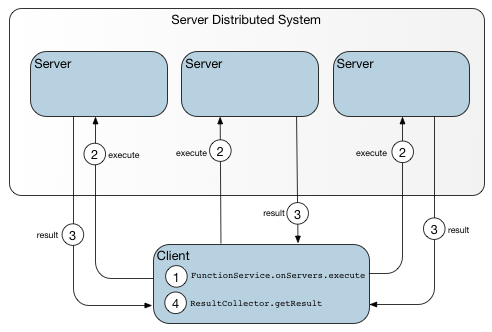

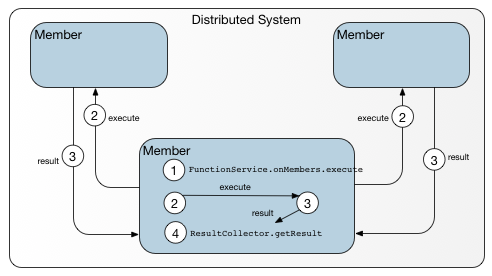

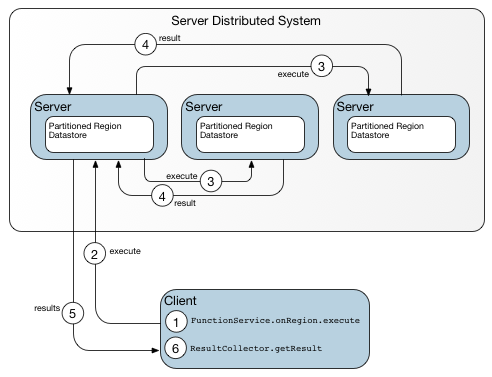

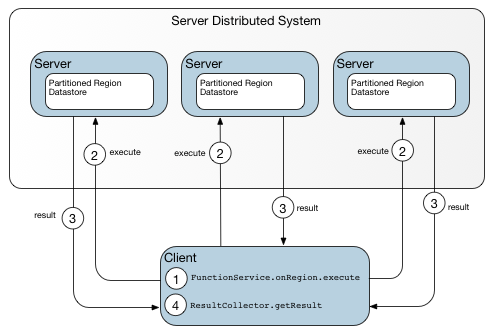

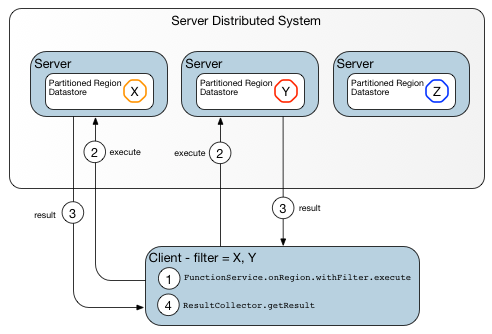

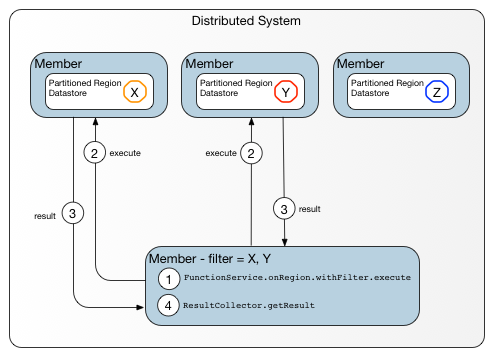

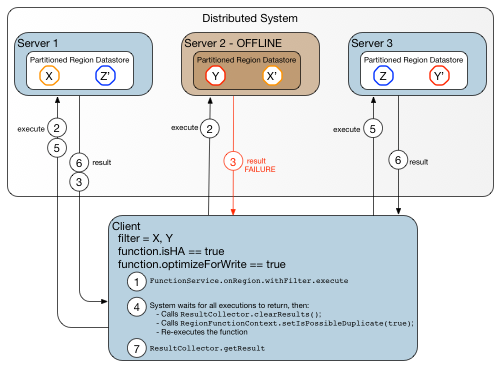

函数是驻留在服务器上的代码体,应用程序可以从客户端或其他服务器调用,而无需自己发送函数代码。 调用者可以指示数据相关函数对特定数据集进行操作,或者可以指示与数据无关的函数在特定服务器,成员或成员组上操作。

区域数据存储和分发

Apache Geode数据存储和分发模型可以在适当的时间将您的数据放在正确的位置。 在配置数据区域之前,您应该了解Geode中数据存储的所有选项。

存储和分配选项

Geode提供了多种数据存储和分发模型,包括分区或复制区域以及分布式或非分布式区域(本地缓存存储)。

区域类型

区域类型定义单个集群中的区域行为。 您可以使用各种区域数据存储和分发选项。

区域数据存储和数据访问器

了解存储区域数据的成员与仅作为区域数据访问者的成员之间的区别。

动态创建区域

您可以在应用程序代码中动态创建区域,并自动在集群成员上实例化它们。

存储和分配选项

Geode提供了多种数据存储和分发模型,包括分区或复制区域以及分布式或非分布式区域(本地缓存存储)。

点对点区域存储和分发

最常见的是,数据管理意味着在应用程序需要的时间和地点提供当前数据。在正确配置的Geode安装中,您将数据存储在本地成员中,Geode会根据您的缓存配置设置自动将其分发给需要它的其他成员。您可能正在存储需要特殊考虑的非常大的数据对象,或者您可能需要仔细配置大量数据以保护应用程序的性能或内存使用。您可能需要能够在特定操作期间显式锁定某些数据。大多数数据管理功能都可以作为配置选项使用,您可以使用gfsh集群配置服务,cache.xml文件或API指定。配置完成后,Geode会自动管理数据。例如,这是您管理数据分发,磁盘存储,数据过期活动和数据分区的方式。通过API在运行时管理一些功能。

在体系结构级别,数据分发在单个群集中的对等体之间以及客户端和服务器之间运行。

- 点对点提供核心分发和存储模型,这些模型被指定为数据区域上的属性。

- 对于客户端/服务器,您可以选择在客户端和服务器层之间共享哪些数据区域。 然后,在每个区域内,您可以通过订阅子集来微调服务器自动发送到客户端的数据。

任何类型的安装中的数据存储都基于每个群集的点对点配置。 数据和事件分发基于点对点和系统到系统配置的组合。

存储和分发模型通过缓存和区域属性进行配置。 主要选择是分区,复制或仅分布式。 必须对所有服务器区域进行分区或复制。 每个区域的data-policy和subscription-attributes,如果它不是分区区域,它的scope进行交互以更好地控制数据分发。

在本地缓存中存储数据

要将数据存储在本地缓存中,请使用带有本地状态的RegionShortcut或ClientRegionShortcut的区域refid。 这些会自动将区域data-policy设置为非空策略。 没有存储的区域可以发送和接收事件分发,而无需在应用程序堆中存储任何内容。 使用其他设置,接收的所有输入操作都存储在本地。

区域类型

区域类型定义单个集群中的区域行为。 您可以使用各种区域数据存储和分发选项。

在Geode集群中,您可以定义分布式区域和非分布式区域,并且可以定义其数据分布在集群中的区域,以及其数据完全包含在单个成员中的区域。

您选择的区域类型部分取决于您运行的应用程序类型。 特别是,您需要为服务器和客户端使用特定的区域类型,以便在两个层之间进行有效通信:

- 服务器区域由服务器在

缓存内创建,并由从服务器集群外部连接到服务器的客户端访问。 服务器区域必须具有分区或复制的区域类型。 服务器区域配置使用RegionShortcut枚举设置。 - 客户端区域由客户端在

ClientCache内创建,并配置为在客户端和服务器层之间分发数据和事件。 客户区域必须具有区域类型local。 客户端区域配置使用ClientRegionShortcut枚举设置。 - 对等区域在

Cache内创建。 对等区域可以是服务器区域,或者它们可以是客户端不访问的区域。 对等区域可以具有任何区域类型。 对等区域配置使用RegionShortcut枚举设置。

使用gfsh或cache.xml文件配置服务器或对等区域时,可以使用region shortcuts来定义您所在区域的基本配置。 区域快捷方式提供了一组默认配置属性,这些属性是为各种类型的缓存体系结构设计的。 然后,您可以根据需要添加其他配置属性以自定义应用程序。 有关这些区域快捷方式的更多信息和完整参考,请参阅区域快捷方式参考.

这些是每个数据区域的主要配置选择。

| 区域类型 | 描述 | 最适合... |

|---|---|---|

| Partitioned | 系统范围的数据集设置。 数据被划分为跨定义区域的成员的桶。 为了实现高可用性,请配置冗余副本,以便每个存储桶存储在多个成员中,其中一个成员持有主数据. | 服务器区域和对等区域: 1.非常大的数据集; 2.高可用性; 3.写性能; 4.分区事件监听器和数据加载器 |

| Replicated (distributed) | 保存分布式区域中的所有数据。 来自分布区域的数据被复制到成员副本区域中。 可以与非复制混合,一些成员持有副本,一些成员持有非副本。 | 服务器区域和对等区域: 1.阅读繁重的小型数据集; 2.异步分配; 3.查询性能 |

| Distributed non-replicated | 数据分布在定义区域的成员之间。 每个成员只保留其表示感兴趣的数据。可以与复制混合,一些成员持有副本,一些成员持有非副本。 | 对等区域,但不是服务器区域和不是客户区域: 异步分配;查询性能 |

| Non-distributed (local) | 该区域仅对定义成员可见。 | 客户区域和对等区域: 1.应用程序之间未共享的数据 |

分区区域

对于非常大的服务器区域,分区是一个不错的选择。 分区区域非常适用于数百GB甚至更多的数据集。

注意: 分区区域通常需要比其他区域类型更多的JDBC连接,因为承载数据的每个成员必须具有连接。

分区区域将数据分组到存储桶中,每个存储桶都存储在所有系统成员的子集中。 存储桶中的数据位置不会影响逻辑视图 - 所有成员都会看到相同的逻辑数据集。

使用分区:

- 大数据集. 存储太大而无法放入单个成员的数据集,并且所有成员都将看到相同的逻辑数据集。 分区区域将数据划分为称为存储区的存储单元,这些存储区分为托管分区区域数据的成员,因此没有成员需要托管所有区域的数据。 Geode提供动态冗余恢复和分区区域的重新平衡,使其成为大规模数据容器的选择。 系统中的更多成员可以在所有主机成员之间实现更均匀的数据平衡,从而允许在添加新成员时扩展系统吞吐量(获取和放置)。

- 高可用性. 分区区域允许您配置Geode应该创建的数据副本数。 如果成员失败,您的数据将在不中断其他成员的情况下可用。 分区区域也可以持久保存到磁盘以获得额外的高可用性。

- 可扩展性. 分区区域可以扩展为大量数据,因为数据在可用于托管区域的成员之间划分。 只需添加新成员即可动态增加数据容量。 分区区域还允许您扩展处理能力。 由于您的条目分布在托管区域的成员中,因此对这些条目的读取和写入也会分散在这些成员中。

- 良好的写性能. 您可以配置数据的副本数量。 每次写入传输的数据量不会随着成员数量的增加而增加。 相反,对于复制区域,每个写入必须发送到具有复制区域的每个成员,因此每次写入传输的数据量随着成员数量的增加而增加。

在分区区域中,您可以在存储桶内和多个分区区域内共存keys。 您还可以控制哪些成员存储哪些数据存储桶。

复制区域

复制区域在吞吐量和延迟方面提供最高性能。 对于中小型服务器区域,复制是一个不错的选择。

使用复制区域:

- 集群的所有成员都需要少量数据. For example, currency rate information and mortgage rates.

- 可以完全包含在单个成员中的数据集. 每个复制区域都包含该区域的完整数据集

- 高性能数据访问. 复制保证了堆对应用程序线程的本地访问,从而为数据访问提供尽可能低的延迟。

- 异步分发. 所有分布式区域(复制和非复制)都提供最快的分发速度。

分布式,非复制区域

分布式区域提供与复制区域相同的性能,但每个成员仅通过订阅来自其他成员的事件或通过在其缓存中定义数据条目来仅存储其表达兴趣的数据。

使用分布式,非复制区域:

- 对等区域,但不是服务器区域或客户区域. 服务器的区域必须是复制或分区。 客户区域必须是本地的。

- 数据集,其中各个成员仅需要通知和更新数据子集的更改. 在非复制区域中,每个成员仅接收其在本地缓存中定义的数据条目的更新事件。

- 异步分发. 所有分布式区域(复制和非复制)都提供最快的分发速度。

本地区域

注意: 当使用ClientRegionShortcut设置创建时,客户端区域自动定义为本地,因为所有客户端分发活动都来自服务器层。

本地区域没有对等分发活动。

使用本地地区:

- 客户区域. 分发仅在客户端和服务器层之间进行。

- 定义成员的私有数据集. 对等成员看不到本地区域。

区域数据存储和数据访问器

了解存储区域数据的成员与仅作为区域数据访问者的成员之间的区别。

在大多数情况下,在成员缓存中定义数据区域时,还要指定该成员是否为数据存储。 存储区域数据的成员称为数据存储或数据主机。 不存储数据的成员称为访问者成员或空成员。 定义区域的任何成员,存储或访问者都可以访问它,将数据放入其中,并从其他成员接收事件。 要配置区域以使成员是数据访问者,请使用不为该区域指定本地数据存储的配置。 否则,该成员是该区域的数据存储。

对于服务器区域,通过在名称中指定包含术语PROXY的区域快捷方式来抑制区域创建时的本地数据存储,例如PARTITION_PROXY或REPLICATE_PROXY。

对于客户端区域,通过指定PROXY区域快捷方式来抑制区域创建时的本地数据存储。 不要使用CACHING_PROXY快捷方式,因为它允许本地数据存储。

动态创建区域

您可以在应用程序代码中动态创建区域,并自动在集群成员上实例化它们。

如果您的应用程序不需要分区区域,则可以使用org.apache.geode.cache.DynamicRegionFactory类动态创建区域,也可以使用cache.xml中的<dynamic-region-factory>元素创建它们。 定义区域的文件。 见.

由于涉及的选项数量众多,大多数开发人员使用函数在其应用程序中动态创建区域,如本主题中所述。 也可以从gfsh命令行创建动态区域。

有关使用Geode函数的完整讨论,请参阅Function Execution。 函数使用org.apache.geode.cache.execute.FunctionService类。

例如,以下Java类定义并使用函数来创建动态区域:

CreateRegionFunction类定义客户端使用FunctionService类的onServer()方法在服务器上调用的函数。 此函数调用通过将条目放入区域属性元数据区域来启动区域创建。 条目key是区域名称,value是用于创建区域的区域属性集。

#CreateRegionFunction.java

import org.apache.geode.cache.Cache;

import org.apache.geode.cache.CacheFactory;

import org.apache.geode.cache.DataPolicy;

import org.apache.geode.cache.Declarable;

import org.apache.geode.cache.Region;

import org.apache.geode.cache.RegionAttributes;

import org.apache.geode.cache.RegionFactory;

import org.apache.geode.cache.Scope;

import org.apache.geode.cache.execute.Function;

import org.apache.geode.cache.execute.FunctionContext;

import java.util.Properties;

public class CreateRegionFunction implements Function, Declarable {

private final Cache cache;

private final Region<String,RegionAttributes> regionAttributesMetadataRegion;

private static final String REGION_ATTRIBUTES_METADATA_REGION =

"_regionAttributesMetadata";

public enum Status {SUCCESSFUL, UNSUCCESSFUL, ALREADY_EXISTS};

public CreateRegionFunction() {

this.cache = CacheFactory.getAnyInstance();

this.regionAttributesMetadataRegion = createRegionAttributesMetadataRegion();

}

public void execute(FunctionContext context) {

Object[] arguments = (Object[]) context.getArguments();

String regionName = (String) arguments[0];

RegionAttributes attributes = (RegionAttributes) arguments[1];

// Create or retrieve region

Status status = createOrRetrieveRegion(regionName, attributes);

// Return status

context.getResultSender().lastResult(status);

}

private Status createOrRetrieveRegion(String regionName,

RegionAttributes attributes) {

Status status = Status.SUCCESSFUL;

Region region = this.cache.getRegion(regionName);

if (region == null) {

// Put the attributes into the metadata region. The afterCreate call will

// actually create the region.

this.regionAttributesMetadataRegion.put(regionName, attributes);

// Retrieve the region after creating it

region = this.cache.getRegion(regionName);

if (region == null) {

status = Status.UNSUCCESSFUL;

}

} else {

status = Status.ALREADY_EXISTS;

}

return status;

}

private Region<String,RegionAttributes>

createRegionAttributesMetadataRegion() {

Region<String, RegionAttributes> metaRegion =

this.cache.getRegion(REGION_ATTRIBUTES_METADATA_REGION);

if (metaRegion == null) {

RegionFactory<String, RegionAttributes> factory =

this.cache.createRegionFactory();

factory.setDataPolicy(DataPolicy.REPLICATE);

factory.setScope(Scope.DISTRIBUTED_ACK);

factory.addCacheListener(new CreateRegionCacheListener());

metaRegion = factory.create(REGION_ATTRIBUTES_METADATA_REGION);

}

return metaRegion;

}

public String getId() {

return getClass().getSimpleName();

}

public boolean optimizeForWrite() {

return false;

}

public boolean isHA() {

return true;

}

public boolean hasResult() {

return true;

}

public void init(Properties properties) {

}

}

CreateRegionCacheListener类是一个缓存侦听器,它实现了两个方法:afterCreate()和afterRegionCreate()。 afterCreate()方法创建区域。 afterRegionCreate()方法使每个新服务器创建元数据区域中定义的所有区域。

#CreateRegionCacheListener.java

import org.apache.geode.cache.Cache;

import org.apache.geode.cache.CacheFactory;

import org.apache.geode.cache.Declarable;

import org.apache.geode.cache.EntryEvent;

import org.apache.geode.cache.Region;

import org.apache.geode.cache.RegionAttributes;

import org.apache.geode.cache.RegionEvent;

import org.apache.geode.cache.RegionExistsException;

import org.apache.geode.cache.util.CacheListenerAdapter;

import java.util.Map;

import java.util.Properties;

public class CreateRegionCacheListener

extends CacheListenerAdapter<String,RegionAttributes>

implements Declarable {

private Cache cache;

public CreateRegionCacheListener() {

this.cache = CacheFactory.getAnyInstance();

}

public void afterCreate(EntryEvent<String,RegionAttributes> event) {

createRegion(event.getKey(), event.getNewValue());

}

public void afterRegionCreate(RegionEvent<String,RegionAttributes> event) {

Region<String,RegionAttributes> region = event.getRegion();

for (Map.Entry<String,RegionAttributes> entry : region.entrySet()) {

createRegion(entry.getKey(), entry.getValue());

}

}

private void createRegion(String regionName, RegionAttributes attributes) {

if (this.cache.getLogger().fineEnabled()) {

this.cache.getLogger().fine(

"CreateRegionCacheListener creating region named: "

+ regionName + " with attributes: " + attributes);

}

try {

Region region = this.cache.createRegionFactory(attributes)

.create(regionName);

if (this.cache.getLogger().fineEnabled()) {

this.cache.getLogger().fine("CreateRegionCacheListener created: "

+ region);

}

System.out.println("CreateRegionCacheListener created: " + region);

} catch (RegionExistsException e) {/* ignore */}

}

public void init(Properties p) {

}

}

分区区域

除基本区域管理外,分区区域还包括高可用性选项,数据位置控制以及跨群集的数据平衡。

了解分区

要使用分区区域,您应该了解它们的工作方式以及管理它们的选项。

配置分区区域

规划主机和访问者成员的分区区域的配置和持续管理,并配置启动区域。

配置分区区域的桶数

确定要分配给分区区域的桶数,并相应地设置配置。

自定义分区和数据共置

您可以自定义Apache Geode如何使用自定义分区和数据同地对分区区域数据进行分组。

配置分区区域的高可用性

默认情况下,Apache Geode仅在区域的数据存储中存储分区区域数据的单个副本。 您可以配置Geode以维护分区区域数据的冗余副本,以实现高可用性。

配置对服务器分区区域的单跳客户端访问

单跳数据访问使客户端池能够跟踪分区区域的数据在服务器中的托管位置。 要访问单个条目,客户端将在一个跃点中直接联系承载key的服务器。

重新平衡分区区域数据

在对成员读取或更新并发线程的争用最小的群集中,您可以使用重新平衡来动态增加或减少数据和处理容量。

检查分区中的冗余

在某些情况下,验证分区区域数据是否为冗余并且在成员重新启动时,已跨分区区域成员正确恢复冗余非常重要。

将分区区域数据移动到另一个成员

您可以使用

PartitionRegionHelper,moveBucketByKey和moveData方法将分区区域数据从一个成员显式移动到另一个成员。

了解分区

要使用分区区域,您应该了解它们的工作方式以及管理它们的选项。

在操作期间,分区区域看起来像一个大的虚拟区域,具有定义区域的所有成员保持相同的逻辑视图。

对于您定义区域的每个成员,您可以选择允许区域数据存储的空间,包括根本没有本地存储。 无论本地存储多少,该成员都可以访问所有区域数据。

群集可以具有多个分区区域,并且可以将分区区域与分布区域和局部区域混合。 除了具有局部范围的区域之外,对于唯一区域名称的通常要求仍然适用。 单个成员可以托管多个分区区域。

数据分区

Geode自动确定托管分区区域数据的成员中数据的物理位置。 Geode将分区区域数据分解为称为存储区的存储单元,并将每个存储区存储在区域主机成员中。 存储桶根据成员的区域属性设置进行分配。

创建条目时,会将其分配给存储桶。 key组合在一个桶中并始终保留在那里。 如果配置允许,则可以在构件之间移动桶以平衡负载。

您必须运行所需的数据存储以适应分区区域的存储区。 您可以动态启动新的数据存储。 当新数据存储创建区域时,它负责分区区域和成员配置允许的桶数。

您可以自定义Geode如何使用自定义分区和数据同地对分区区域数据进行分组。

分区区域操作

分区区域的运行方式与分区范围的非分区区域非常相似。 大多数标准的Region方法都是可用的,尽管一些通常是本地操作的方法成为分布式操作,因为它们作为一个整体而不是本地缓存在分区区域上工作。 例如,分区区域中的put或create实际上可能不会存储到调用该操作的成员的高速缓存中。 检索任何条目只需要成员之间不超过一跳。

与其他区域一样,分区区域支持客户端/服务器模型。 如果需要将数十个客户端连接到单个分区区域,则使用服务器可以大大提高性能。

有关分区区域的其他信息

请记住有关分区区域的以下内容:

- 分区区域永远不会异步运行。 分区区域中的操作始终等待来自包含原始数据条目和任何冗余副本的高速缓存的确认。

- 分区区域需要每个区域数据存储中的缓存加载器(

local-max-memory> 0)。 - Geode在存储分区区域数据的所有成员之间尽可能均匀地分布数据桶,在您使用的任何自定义分区或数据同地的限制内。 分配区域分配的桶数决定了数据存储的粒度,从而决定了数据的均匀分布。 存储桶的数量是整个群集中整个区域的总数。

- 在重新平衡该地区的数据时,Geode移动存储桶,但不会在存储桶内移动数据。

- 您可以查询分区区域,但存在某些限制。 有关详细信息,请参阅查询分区区域 。

配置分区区域

规划主机和访问者成员的分区区域的配置和持续管理,并配置启动区域。

在开始之前,请了解基本配置和编程.

- 使用

PARTITION区域快捷键设置之一启动区域配置。 请参见区域快捷方式和自定义命名区域属性. - 如果您需要分区区域的高可用性,请为此配置。 请参见为分区区域配置高可用性.

- 估算该地区所需的空间量。 如果使用冗余,则这是存储在成员中的所有主副本和副副本的最大值。 例如,冗余为1时,每个区域数据条目需要的空间是没有冗余的两倍,因为条目存储了两次。 请参阅缓存数据的内存要求.

- 配置该区域的桶总数。 对于同地区域,此数字必须相同。 请参见配置分区区域的桶数.

- 为区域配置成员的数据存储和数据加载:

- 您可以让没有本地数据存储的成员和具有不同存储量的成员。 确定此区域的不同成员类型中可用的最大内存。 这些将在

partition-attributeslocal-max-memory中设置。 这是partition-attributes中唯一可以在成员之间变化的设置。 使用这些最大值和您对区域内存要求的估计值来帮助您计算该区域开始的成员数量。 - 对于存储区域数据的成员(

local-max-memory大于0),定义数据加载器。 请参阅实现数据加载器. - 如果您的成员没有本地数据存储(

local-max-memory设置为0),请检查系统启动/关闭过程。 当任何没有存储的成员正在运行时,请确保始终至少有一个成员具有本地数据存储。

- 您可以让没有本地数据存储的成员和具有不同存储量的成员。 确定此区域的不同成员类型中可用的最大内存。 这些将在

- 如果要自定义对区域中的数据进行分区,或者在多个区域之间同地数据,请相应地进行编码和配置。 请参阅了解自定义分区和数据同地.

- 规划您的分区重新平衡策略并为其配置和编程。 请参阅重新平衡分区区域数据.

注意: 要使用gfsh配置分区区域,请参阅gfsh命令帮助.

配置分区区域的桶数

确定要分配给分区区域的桶数,并相应地设置配置。

分区区域的存储区总数决定了数据存储的粒度,从而决定了数据的均匀分布。 Geode在数据存储中尽可能均匀地分配存储桶。 区域创建后,桶的数量是固定的。

分区属性total-num-buckets设置所有参与成员的整个分区区域的编号。 使用以下之一设置它:

XML:

<region name="PR1"> <region-attributes refid="PARTITION"> <partition-attributes total-num-buckets="7"/> </region-attributes> </region>Java:

RegionFactory rf = cache.createRegionFactory(RegionShortcut.PARTITION); rf.setPartitionAttributes(new PartitionAttributesFactory().setTotalNumBuckets(7).create()); custRegion = rf.create("customer");gfsh:

使用

create region命令的-total-num-buckets参数。 例如:gfsh>create region --name="PR1" --type=PARTITION --total-num-buckets=7

计算分区区域的桶总数

请遵循以下准则来计算分区区域的存储区总数:

- 使用素数。 这提供了最均匀的分布。

- 使其至少是您期望为该地区拥有的数据存储数量的四倍。 存储桶与数据存储的比率越大,负载在成员之间的分布越均匀。 但请注意,在负载平衡和开销之间存在折衷。 管理存储桶会带来很大的开销,尤其是冗余级别更高。

您试图避免某些成员拥有的数据条目明显多于其他成员的情况。 例如,比较接下来的两个数字。 该图显示了具有三个数据存储区和七个存储区的区域。 如果以大约相同的速率访问所有条目,则此配置在成员M3中创建热点,其具有比其他数据存储多大约50%的数据。 M3可能是一个缓慢的接收器和潜在的故障点。

配置更多存储桶可使存储桶中的条目更少,数据分布更均衡。 此图使用与以前相同的数据,但将桶数增加到13.现在数据条目的分布更均匀。

自定义分区和共享数据

您可以自定义Apache Geode如何使用自定义分区和数据同地对分区区域数据进行分组。

了解自定义分区和数据同地

自定义分区和数据同地可以单独使用,也可以相互结合使用。

标准自定义分区

默认情况下,Geode使用key上的散列策略将每个数据条目分区到一个存储桶中。 此外,键值对的物理位置从应用程序中抽象出来。 您可以通过提供标准分区解析程序来更改分区区域的这些策略,该分区解析程序将条目映射到称为分区的一组存储区。

固定的自定义分区

默认情况下,Geode使用key上的散列策略将每个数据条目分区到一个存储桶中。 此外,键值对的物理位置从应用程序中抽象出来。 您可以通过提供固定分区解析程序来更改分区区域的这些策略,该解析程序不仅将条目映射到称为分区的一组存储区,还指定哪些成员承载哪些数据存储区。

共享来自不同分区区域的数据

默认情况下,Geode为独立于任何其他分区区域的数据位置的分区区域分配数据位置。 您可以为任何分区区域组更改此策略,以便跨区域相关数据全部由同一成员托管。 某些操作需要进行同地,并通过减少对其他集群成员上托管的条目的数据访问次数来提高其他操作的性能。

了解自定义分区和数据同地

自定义分区和数据同地可以单独使用,也可以相互结合使用。

自定义分区

使用自定义分区将类似条目分组到区域内的区域存储桶中。 默认情况下,Geode根据条目键的哈希码为桶分配新条目。 通过自定义分区,您可以以任何方式将条目分配给存储桶。

如果使用自定义分区对区域内的类似数据进行分组,通常可以获得更好的性能。 例如,如果所有1月帐户数据都由单个成员托管,则在1月创建的所有帐户上运行的查询运行得更快。 为单个客户分组所有数据可以提高处理客户数据的数据操作的性能。 数据感知功能执行还利用了自定义分区。

使用自定义分区,您有两种选择:

标准自定义分区. 使用标准自定义分区,您可以将条目分组到存储区中,但不指定存储区所在的位置。 Geode始终将条目保留在您指定的存储区中,但可以移动存储区以进行负载平衡。 请参阅标准自定义分区 for implementation and configuration details.

固定的自定义分区. 使用固定的自定义分区,您可以指定每个区域条目所在的确切成员。 您将条目分配给分区,然后分配给该分区中的存储桶。 您将特定成员命名为每个分区的主要和辅助主机。

这使您可以完全控制该区域的主要和任何辅助存储桶的位置。 当您希望在特定物理机器上存储特定数据或需要将数据保持在某些硬件元素附近时,这非常有用。

固定分区具有以下要求和注意事项:

- Geode无法重新平衡固定分区区域数据,因为它无法在主机成员之间移动存储桶。 您必须仔细考虑您创建的分区的预期数据加载。

- 使用固定分区,主机成员之间的区域配置不同。 每个成员都标识它承载的命名分区,以及它是托管主副本还是主副本。 然后,您可以对固定分区解析程序进行编程以返回分区ID,因此该条目位于右侧成员上。 对于特定分区名称,只有一个成员可以是主要成员,并且该成员不能是该分区的辅助成员。

有关实现和配置细节,请参见固定自定义分区 。

区域之间的数据同地

通过数据同地,Geode在单个成员中存储跨多个数据区域相关的条目。 Geode通过将具有相同ID的所有区域桶一起存储在同一成员中来实现此目的。 在重新平衡操作期间,Geode将这些桶组移动到一起或根本不移动。

因此,例如,如果您有一个区域包含客户联系信息,另一个区域包含客户订单,您可以使用托管将单个客户的所有联系信息和所有订单保存在一个成员中。 这样,对单个客户执行的任何操作都只使用单个成员的缓存。

此图显示了具有数据同地的两个区域,其中数据按客户类型进行分区。

数据同地需要对所有同地区域使用相同的数据分区机制。 您可以使用Geode提供的默认分区或任何自定义分区策略。

您必须在同地区域中使用相同的高可用性设置。

有关实施和配置详细信息,请参阅来自不同分区区域的共存数据。

标准自定义分区

默认情况下,Geode使用key上的散列策略将每个数据条目分区到一个存储桶中。 此外,键值对的物理位置从应用程序中抽象出来。 您可以通过提供以自定义方式映射条目的标准自定义分区解析程序来更改分区区域的这些策略。

注意: 如果要同时进行区域数据和自定义分区,则所有同地区域必须使用相同的自定义分区机制。 请参阅来自不同分区区域的共存数据.

要自定义分区您的区域数据,请执行以下两个步骤:

- 实现接口

- 配置区域

实现标准自定义分区

以下列方式之一实现

org.apache.geode.cache.PartitionResolver接口,在Geode使用的搜索顺序中列出:- 使用自定义类. 在类中实现

PartitionResolver,然后在创建区域时将类指定为分区解析器。 - 使用key的类. 让条目key的类实现

PartitionResolver接口。 - 使用回调参数的类. 让实现你的回调参数的类实现

PartitionResolver接口。 使用此实现时,任何和所有Region操作必须是指定回调参数的操作。

- 使用自定义类. 在类中实现

实现解析器的

getName,init和close方法。getName的简单实现是return getClass().getName();init方法在高速缓存启动时执行与分区解析器任务相关的任何初始化步骤。 仅当使用由gfsh或XML(在cache.xml文件中)配置的自定义类时才会调用此方法。close方法完成在缓存关闭完成之前必须完成的任何清理。 例如,close可能会关闭分区解析器打开的文件或连接。实现解析器的

getRoutingObject方法以返回每个条目的路由对象。 返回的路由对象的哈希值确定存储桶。 因此,getRoutingObject应该返回一个对象,该对象在通过其hashCode运行时,将分组对象定向到所需的存储桶。注意: 只有

getKey返回的键应该由getRoutingObject使用。 不要在getRoutingObject的实现中使用与键相关联的值或任何其他元数据。 不要使用getOperation或getValue。

实现字符串前缀分区解析器

Geode在org.apache.geode.cache.util.StringPrefixPartitionResolver中提供了基于字符串的分区解析器的实现。 该解析器不需要任何进一步的实现。 它根据key的一部分将条目分组到存储桶中。 所有键必须是字符串,每个键必须包含一个’|’字符,用于分隔字符串。 在键中的’|’分隔符之前的子字符串将由getRoutingObject返回。

配置分区解析程序区域属性

配置区域,以便Geode找到所有区域操作的解析器。

自定义类. 使用以下方法之一指定分区解析程序区域属性:

gfsh:

将选项

--partition-resolver添加到gfsh create region命令,指定标准自定义分区解析程序的包和类名。字符串前缀分区解析器的gfsh:

将

--partition-resolver = org.apache.geode.cache.util.StringPrefixPartitionResolver选项添加到gfsh create region命令。Java API:

PartitionResolver resolver = new TradesPartitionResolver(); PartitionAttributes attrs = new PartitionAttributesFactory() .setPartitionResolver(resolver).create(); Cache c = new CacheFactory().create(); Region r = c.createRegionFactory() .setPartitionAttributes(attrs) .create("trades");字符串前缀分区解析器的Java API:

PartitionAttributes attrs = new PartitionAttributesFactory() .setPartitionResolver(new StringPrefixPartitionResolver()).create(); Cache c = new CacheFactory().create(); Region r = c.createRegionFactory() .setPartitionAttributes(attrs) .create("customers");XML:

<region name="trades"> <region-attributes> <partition-attributes> <partition-resolver> <class-name>myPackage.TradesPartitionResolver </class-name> </partition-resolver> <partition-attributes> </region-attributes> </region>字符串前缀分区解析器的XML:

<region name="customers"> <region-attributes> <partition-attributes> <partition-resolver> <class-name>org.apache.geode.cache.util.StringPrefixPartitionResolver </class-name> </partition-resolver> <partition-attributes> </region-attributes> </region>如果您的同地数据位于服务器系统中,请将

PartitionResolver实现类添加到Java客户端的CLASSPATH中。 对于Java单跳访问,解析器类需要具有零参数构造函数,并且解析器类不能具有任何状态;init方法包含在此限制中。

固定的自定义分区

默认情况下,Geode使用密钥上的散列策略将每个数据条目分区到一个存储桶中。 此外,键值对的物理位置从应用程序中抽象出来。 您可以通过提供固定的自定义分区解析程序来更改分区区域的这些策略,该解析程序不仅将条目映射到称为分区的一组存储区,还指定哪些成员承载哪些数据存储区。

注意: 如果要同时进行区域数据和自定义分区,则所有同地区域必须使用相同的自定义分区机制。 请参阅来自不同分区区域的同地数据.

要自定义分区您的区域数据,请执行以下两个步骤:

- 实现接口

- 配置区域

这些步骤根据使用的分区解析程序而有所不同。

实现固定自定义分区

在以下位置之一中实现

org.apache.geode.cache.FixedPartitionResolver接口,这些位置在Geode使用的搜索顺序中列出:- 自定义类. 在区域创建期间将此类指定为分区解析程序。

- 条目 key. 对于作为对象实现的键,定义键类的接口。

- 在缓存回调类中. 在缓存回调的类中实现接口。 使用此实现时,任何和所有

Region操作必须是将回调指定为参数的操作。

实现解析器的

getName,init和close方法。getName的简单实现是return getClass().getName();init方法在高速缓存启动时执行与分区解析器任务相关的任何初始化步骤。close方法完成在缓存关闭完成之前必须完成的任何清理。 例如,close可能会关闭分区解析器打开的文件或连接。实现解析器的

getRoutingObject方法以返回每个条目的路由对象。 返回的路由对象的哈希值确定分区内的存储区。对于每个分区只有一个存储区的固定分区,此方法可以为空。 该实现将分区分配给服务器,以便应用程序完全控制服务器上的分组条目。

注意: 创建路由对象时,只应使用key上的字段。 不要为此目的使用值或其他元数据。

实现

getPartitionName方法,根据您希望条目驻留的位置,为每个条目返回分区的名称。 分区中的所有条目都将位于单个服务器上。此示例根据日期放置数据,每个季度使用不同的分区名称,每个月使用不同的路由对象。

/** * Returns one of four different partition names * (Q1, Q2, Q3, Q4) depending on the entry's date */ class QuarterFixedPartitionResolver implements FixedPartitionResolver<String, String> { @Override public String getPartitionName(EntryOperation<String, String> opDetails, Set<String> targetPartitions) { Date date = (Date)opDetails.getKey(); Calendar cal = Calendar.getInstance(); cal.setTime(date); int month = cal.get(Calendar.MONTH); if (month >= 0 && month < 3) { if (targetPartitions.contains("Q1")) return "Q1"; } else if (month >= 3 && month < 6) { if (targetPartitions.contains("Q2")) return "Q2"; } else if (month >= 6 && month < 9) { if (targetPartitions.contains("Q3")) return "Q3"; } else if (month >= 9 && month < 12) { if (targetPartitions.contains("Q4")) return "Q4"; } return "Invalid Quarter"; } @Override public String getName() { return "QuarterFixedPartitionResolver"; } @Override public Serializable getRoutingObject(EntryOperation<String, String> opDetails) { Date date = (Date)opDetails.getKey(); Calendar cal = Calendar.getInstance(); cal.setTime(date); int month = cal.get(Calendar.MONTH); return month; } @Override public void close() { } }

配置固定自定义分区

为每个成员设置固定分区属性。

这些属性定义成员为区域存储的数据,并且对于不同的成员必须是不同的。 有关属性的定义,请参阅

org.apache.geode.cache.FixedPartitionAttributes。 在区域的数据主机成员中定义每个partition-name。 对于每个分区名称,在要托管主副本的成员中,使用is-primary设置为true来定义它。 在要托管辅助副本的每个成员中,使用is-primary设置为false(默认值)来定义它。 辅助数量必须与您为该区域定义的冗余副本数相匹配。 请参见为分区区域配置高可用性.注意: 分区的存储桶仅由已在其

FixedPartitionAttributes中定义分区名称的成员托管。这些示例将成员的分区属性设置为“Q1”分区数据的主要主机和“Q3”分区数据的辅助主机。

XML:

<cache> <region name="Trades"> <region-attributes> <partition-attributes redundant-copies="1"> <partition-resolver> <class-name>myPackage.QuarterFixedPartitionResolver</class-name> </partition-resolver> <fixed-partition-attributes partition-name="Q1" is-primary="true"/> <fixed-partition-attributes partition-name="Q3" is-primary="false" num-buckets="6"/> </partition-attributes> </region-attributes> </region> </cache>Java:

FixedPartitionAttribute fpa1 = FixedPartitionAttributes .createFixedPartition("Q1", true); FixedPartitionAttribute fpa3 = FixedPartitionAttributes .createFixedPartition("Q3", false, 6); PartitionAttributesFactory paf = new PartitionAttributesFactory() .setPartitionResolver(new QuarterFixedPartitionResolver()) .setTotalNumBuckets(12) .setRedundantCopies(2) .addFixedPartitionAttribute(fpa1) .addFixedPartitionAttribute(fpa3); Cache c = new CacheFactory().create(); Region r = c.createRegionFactory() .setPartitionAttributes(paf.create()) .create("Trades");gfsh:

您不能使用gfsh指定固定分区解析程序。

如果您的同地数据位于服务器系统中,请将实现

FixedPartitionResolver接口的类添加到Java客户端的CLASSPATH中。 对于Java单跳访问,解析器类需要具有零参数构造函数,并且解析器类不能具有任何状态;init方法包含在此限制中。

共享来自不同分区区域的数据

默认情况下,Geode为独立于任何其他分区区域的数据位置的分区区域分配数据位置。 您可以为任何分区区域组更改此策略,以便跨区域相关数据全部由同一成员托管。 某些操作需要进行同地,并通过减少对其他集群成员上托管的条目的数据访问次数来提高其他操作的性能。

分区区域之间的数据同地通常可以提高数据密集型操作的性能。 您可以减少网络跃点,以便对相关数据集进行迭代操作。 数据密集型的计算密集型应用程序可以显着提高整体吞吐量。 例如,如果所有数据都分组在一个成员中,则对患者的健康记录,保险和账单信息运行的查询会更有效。 同样,如果所有交易,风险敏感度和与单个工具相关的参考数据在一起,则金融风险分析应用程序运行得更快。

步骤

将一个区域标识为中心区域,明确地将其他区域中的数据与其区分开来。 如果对任何区域使用持久性,则必须保留中心区域。

在创建其他区域之前创建中心区域,可以在

cache.xml或代码中创建。 XML中的区域是在代码中的区域之前创建的,因此如果在XML中创建任何共处区域,则必须先在XML中创建中心区域,然后再创建其他区域。 Geode将在其他人创建时验证其存在,如果中心区域不存在则返回IllegalStateException。 不要向此中心区域添加任何托管规范。对于所有其他区域,在区域分区属性中,在

colocated-with属性中提供中心区域的名称。 使用以下方法之一:XML:

<cache> <region name="trades"> <region-attributes> <partition-attributes> ... <partition-attributes> </region-attributes> </region> <region name="trade_history"> <region-attributes> <partition-attributes colocated-with="trades"> ... <partition-attributes> </region-attributes> </region> </cache>Java:

PartitionAttributes attrs = ... Region trades = new RegionFactory().setPartitionAttributes(attrs) .create("trades"); ... attrs = new PartitionAttributesFactory().setColocatedWith(trades.getFullPath()) .create(); Region trade_history = new RegionFactory().setPartitionAttributes(attrs) .create("trade_history");gfsh:

gfsh>create region --name="trades" type=PARTITION gfsh> create region --name="trade_history" --colocated-with="trades"

对于每个同地区域,对与存储区管理相关的这些分区属性使用相同的值:

recovery-delayredundant-copiesstartup-recovery-delaytotal-num-buckets

如果您自定义分区您的区域数据,请为所有同地区域指定自定义解析程序。 此示例对两个区域使用相同的分区解析程序:

XML:

<cache> <region name="trades"> <region-attributes> <partition-attributes> <partition-resolver name="TradesPartitionResolver"> <class-name>myPackage.TradesPartitionResolver </class-name> <partition-attributes> </region-attributes> </region> <region name="trade_history"> <region-attributes> <partition-attributes colocated-with="trades"> <partition-resolver name="TradesPartitionResolver"> <class-name>myPackage.TradesPartitionResolver </class-name> <partition-attributes> </region-attributes> </region> </cache>Java:

PartitionResolver resolver = new TradesPartitionResolver(); PartitionAttributes attrs = new PartitionAttributesFactory() .setPartitionResolver(resolver).create(); Region trades = new RegionFactory().setPartitionAttributes(attrs) .create("trades"); attrs = new PartitionAttributesFactory() .setColocatedWith(trades.getFullPath()).setPartitionResolver(resolver) .create(); Region trade_history = new RegionFactory().setPartitionAttributes(attrs) .create("trade_history");gfsh:

指定分区解析程序,如[自定义分区您的区域数据]的配置部分所述(https://geode.apache.org/docs/guide/17/developing/partitioned_regions/using_custom_partition_resolvers.html).

如果要在同地区域中保留数据,请保留中心区域,然后根据需要保留其他区域。 对您保留的所有共存区域使用相同的磁盘存储。

配置分区区域的高可用性

默认情况下,Apache Geode仅在区域的数据存储中存储分区区域数据的单个副本。 您可以配置Geode以维护分区区域数据的冗余副本,以实现高可用性。

了解分区区域的高可用性

凭借高可用性,为分区区域托管数据的每个成员都会获得一些主副本和一些冗余(辅助)副本。

配置分区区域的高可用性

为分区区域配置内存中高可用性。 设置其他高可用性选项,例如冗余区域和冗余恢复策略。

了解分区区域的高可用性

凭借高可用性,为分区区域托管数据的每个成员都会获得一些主副本和一些冗余(辅助)副本。

使用冗余时,如果一个成员发生故障,则操作将在分区区域继续运行,而不会中断服务:

- 如果托管主副本的成员丢失,Geode会将辅助副本作为主副本。 这可能会导致暂时的冗余丢失,但不会导致数据丢失。

- 只要没有足够的辅助副本来满足冗余,系统就会通过将另一个成员分配为辅助副本并将数据复制到其中来恢复冗余。

注意: 如果足够的成员在足够短的时间内发生故障,您仍然可以在使用冗余时丢失缓存数据。

您可以配置系统在不满足时如何恢复冗余。 您可以将恢复配置为立即执行,或者,如果您希望为替换成员提供启动机会,则可以配置等待期。 在任何分区数据重新平衡操作期间,还会自动尝试冗余恢复。 使用gemfire.MAX_PARALLEL_BUCKET_RECOVERIES系统属性配置并行恢复的最大桶数。 默认情况下,系统尝试恢复冗余时,最多可并行恢复8个存储桶。

如果没有冗余,丢失任何区域的数据存储都会导致丢失某些区域的缓存数据。 通常,当应用程序可以直接从其他数据源读取,或者写入性能比读取性能更重要时,不应使用冗余。

控制你的初级和二级居住地

默认情况下,Geode会为您放置主数据副本和辅助数据副本,从而避免在同一台物理计算机上放置两个副本。 如果没有足够的机器将不同的副本分开,Geode会将副本放在同一台物理计算机上。 您可以更改此行为,因此Geode仅将副本放在不同的计算机上。

您还可以控制哪些成员存储主数据副本和辅助数据副本。 Geode提供两种选择:

- 固定自定义分区. 为该区域设置此选项。 固定分区使您可以绝对控制托管区域数据的位置。 通过固定分区,您可以为Geode提供代码,该代码为区域中的每个数据条目指定存储桶和数据存储。 将此选项与冗余配合使用时,可以指定主数据存储和辅助数据存储。 固定分区不参与重新平衡,因为您固定了所有存储桶位置。

- 冗余区域. 此选项在成员级别设置。 冗余区域允许您按成员组或区域分隔主副本副本。 您将每个数据主机分配给区域。 然后Geode将冗余副本放在不同的冗余区域中,就像在不同的物理机器上放置冗余副本一样。 您可以使用此选项在不同的机架或网络中拆分数据副本。此选项允许您动态添加成员并使用重新平衡来重新分配数据负载,并在单独的区域中维护冗余数据。 使用冗余区域时,Geode不会在同一区域中放置两个数据副本,因此请确保您有足够的区域。

在虚拟机中运行进程

默认情况下,Geode将冗余副本存储在不同的计算机上。 在虚拟机中运行进程时,计算机的常规视图将成为VM而非物理计算机。 如果在同一台物理计算机上运行多个VM,则最终可能会将分区区域主存储区存储在单独的VM中,但与第二个存储区位于同一物理计算机上。 如果物理机出现故障,您可能会丢失数据。 在VM中运行时,可以将Geode配置为标识物理计算机并将冗余副本存储在不同的物理计算机上。

在高可用分区区域中进行读写

Geode在高可用性分区区域中对读取和写入的处理方式与在其他区域中不同,因为数据在多个成员中可用:

- 写操作(如

put和create)转到数据键的主要操作,然后同步分发到冗余副本。 事件被发送到配置了subscription-attributesintece-policy设置为all的成员。 - 读操作会转到任何持有数据副本的成员,并且本地缓存很受欢迎,因此读取密集型系统可以更好地扩展并处理更高的负载。

在此图中,M1正在读取W,Y和Z.它直接从其本地副本获取W. 由于它没有Y或Z的本地副本,因此它会进入缓存,随机选择源缓存。

配置分区区域的高可用性

为分区区域配置内存中高可用性。 设置其他高可用性选项,例如冗余区域和冗余恢复策略。

以下是为分区区域配置高可用性的主要步骤。 请参阅后面的部分了解详情

- 设置系统应保留区域数据的冗余副本数。 请参阅设置冗余份数.

- (可选)如果要将数据存储成员分组到冗余区域,请相应地进行配置。 请参见为成员配置冗余区域.

- (可选)如果希望Geode仅将冗余副本放在不同的物理计算机上,请为此配置。 请参阅设置强制唯一主机.

- 决定如何管理冗余恢复并根据需要更改Geode的默认行为。

- 成员崩溃后. 如果要进行自动冗余恢复,请更改其配置。 请参见为分区区域配置成员崩溃冗余恢复.

- 成员加入后. 如果您不希望立即进行自动冗余恢复,请更改配置。 请参见为分区区域配置成员加入冗余恢复.

- 确定Geode在执行冗余恢复时应尝试并行恢复的桶数。 默认情况下,系统最多可并行恢复8个存储桶。 使用

gemfire.MAX_PARALLEL_BUCKET_RECOVERIES系统属性可以在执行冗余恢复时增加或减少并行恢复的最大桶数。 - 对于除固定分区区域之外的所有区域,请查看启动重新平衡的点。 冗余恢复在任何重新平衡开始时自动完成。 如果在成员崩溃或加入后没有自动恢复运行,这是最重要的。 请参阅重新平衡分区区域数据.

在运行时,您可以通过添加区域的新成员来添加容量。 对于不使用固定分区的区域,您还可以启动重新平衡操作以在所有成员之间传播区域存储桶。

设置冗余副本数

通过指定要在区域数据存储中维护的辅助副本数,为分区区域配置内存中高可用性。

为成员配置冗余区域

将成员分组到冗余区域,以便Geode将冗余数据副本分成不同的区域。

设置强制唯一主机

将Geode配置为仅使用唯一的物理机器来分区区域数据的冗余副本。

为分区区域配置成员崩溃冗余恢复

配置成员崩溃后是否以及如何在分区区域中恢复冗余。

为分区区域配置成员加入冗余恢复

配置成员加入后是否以及如何在分区区域中恢复冗余。

设置冗余副本数

通过指定要在区域数据存储中维护的辅助副本数,为分区区域配置内存中高可用性。

在分区属性redundant-copies设置中指定分区区域数据所需的冗余副本数。 默认设置为0。

例如:

XML:

<region name="PR1"> <region-attributes refid="PARTITION"> <partition-attributes redundant-copies="1"/> </region-attributes> </region>Java:

PartitionAttributes pa = new PartitionAttributesFactory().setRedundantCopies(1).create();gfsh:

gfsh>create region --name="PR1" --type=PARTITION --redundant-copies=1

为成员配置冗余区域

将成员分组到冗余区域,以便Geode将冗余数据副本分成不同的区域。

了解如何设置成员的'gemfire.properties`设置。 见参考.

使用gemfire.properties设置redundancy-zone将分区区域主机分组到冗余区域。

例如,如果将冗余设置为1,那么每个数据条目都有一个主副本和一个副副本,则可以通过为每个机架定义一个冗余区域,在两个计算机机架之间拆分主数据副本和辅助数据副本。 为此,您可以在gemfire.properties中为在一个机架上运行的所有成员设置此区域:pre redundancy-zone = rack1

你可以为另一个机架上的所有成员设置这个区域gemfire.properties:pre redundancy-zone = rack2

每个辅助副本都将托管在托管其主要副本的机架对面的机架上。

设置强制唯一主机

将Geode配置为仅使用唯一的物理机器来分区区域数据的冗余副本。

Understand how to set a member’s gemfire.properties settings. See Reference.

配置您的成员,以便Geode始终使用不同的物理机器使用gemfire.properties设置enforce-unique-host来分区区域数据的冗余副本。 此设置的默认值为false。

例子:

enforce-unique-host=true

为分区区域配置成员崩溃冗余恢复

配置成员崩溃后是否以及如何在分区区域中恢复冗余。

使用partition属性recovery-delay指定成员崩溃冗余恢复。

| 恢复延迟分区属性 | 会员失败后的效果 |

|---|---|

| -1 | 成员失败后无法自动恢复冗余。 这是默认值。 |

| 大于或等于0 | 在恢复冗余之前成员发生故障后要等待的毫秒数。 |

默认情况下,成员崩溃后不会恢复冗余。 如果您希望快速重新启动大多数崩溃的成员,将此默认设置与成员加入冗余恢复相结合可以帮助您在成员关闭时避免不必要的数据重排。 通过等待丢失的成员重新加入,使用新启动的成员完成冗余恢复,并且使用较少的处理来更好地平衡分区。

使用以下方法之一设置崩溃冗余恢复:

XML:

// Give a crashed member 10 seconds to restart // before recovering redundancy <region name="PR1"> <region-attributes refid="PARTITION"> <partition-attributes recovery-delay="10000"/> </region-attributes> </region>Java:

PartitionAttributes pa = new PartitionAttributesFactory().setRecoveryDelay(10000).create();gfsh:

gfsh>create region --name="PR1" type=PARTITION --recovery-delay=10000

为分区区域配置成员加入冗余恢复

本节介绍配置成员加入后是否以及如何在分区区域中恢复冗余。

使用partition属性startup-recovery-delay指定成员加入冗余恢复。

startup-recovery-delay的值 |

成员加入后的效果 |

|---|---|

| -1 | 新成员上线后无法自动恢复冗余。 使用此值和默认的recovery-delay设置,冗余恢复仅通过重新平衡操作来实现。 |

| long >= 0 | 成员加入恢复冗余之前等待的毫秒数。 默认值为0(零),只要承载分区区域的成员加入,就会立即执行冗余恢复。 |

将startup-recovery-delay设置为高于默认值0的值允许多个新成员在冗余恢复开始之前加入。 在恢复期间存在多个成员时,系统将在它们之间扩展冗余恢复。 如果没有延迟,如果紧密连续启动多个成员,则系统可以仅选择为大多数或所有冗余恢复启动的第一个成员。

注意: 满足冗余与增加容量不同。 如果满足冗余,则新成员在调用重新平衡操作之前不会获取桶。

并行恢复实施迅速恢复。 因此,在同时重新启动多个成员时,将startup-recovery-delay配置为适当的值更为重要。 将startup-recovery-delay设置为一个值,确保所有成员在冗余恢复启动之前都已启动并可用。

使用以下方法之一设置加入冗余恢复:

XML:

// Wait 5 seconds after a new member joins before // recovering redundancy <region name="PR1"> <region-attributes refid="PARTITION"> <partition-attributes startup-recovery-delay="5000"/> </region-attributes> </region>Java:

PartitionAttributes pa = new PartitionAttributesFactory().setStartupRecoveryDelay(5000).create();gfsh:

gfsh>create region --name="PR1" --type=PARTITION --startup-recovery-delay=5000

配置对服务器分区区域的单跳客户端访问

单跳数据访问使客户端池能够跟踪分区区域的数据在服务器中的托管位置。 要访问单个条目,客户端将在一个跃点中直接联系承载key的服务器。

了解客户端对服务器分区区域的单跳访问

通过单跳访问,客户端连接到每个服务器,因此通常使用更多连接。 这适用于较小的安装,但是缩放的障碍。

配置客户端对服务器分区区域的单跳访问

配置客户端/服务器系统,以便直接,单跳访问服务器中的分区区域数据。

了解客户端对服务器分区区域的单跳访问

通过单跳访问,客户端连接到每个服务器,因此通常使用更多连接。 这适用于较小的安装,但是缩放的障碍。

如果您具有包含许多客户端的大型安装,则可能需要通过在池声明中将池属性pr-single-hop-enabled设置为false来禁用单跳。

如果没有单跳,客户端将使用任何可用的服务器连接,与所有其他操作相同。 接收请求的服务器确定数据位置并与主机联系,主机可能是不同的服务器。 因此,对服务器系统进行了更多的多跳请求。

注意: 单跳用于以下操作:put,get,destroy,putAll,getAll,removeAll和onRegion函数执行。

即使启用了单跳访问,您偶尔也会看到一些多跳行为。 要执行单跳数据访问,客户端会自动从服务器获取有关托管条目所在位置的元数据。 元数据是懒惰的。 它仅在单跳操作最终需要多跳之后更新,这是客户端中陈旧元数据的指示。

单跳和池最大连接设置

不要在启用单跳的情况下设置池的max-connections设置。 使用单跳限制池的连接可能会导致连接抖动,吞吐量丢失和服务器日志膨胀。

如果您需要限制池的连接,请禁用单跳或密切关注系统中的这些负面影响。

但是,对连接设置无限制可能会导致与服务器的连接过多,从而可能导致您遇到系统的文件句柄限制。 检查您预期的连接使用情况,并确保您的服务器能够容纳它。

平衡单跳服务器连接使用

当您的服务器之间的数据访问平衡良好时,单跳可带来最大的好处。 特别是,如果您将这些负载组合在一起,客户端/服务器连接的负载可能会失去平衡:

- 作为空数据访问器或不承载客户端通过单键操作访问的数据的服务器

- 来自客户的许多单键操作

如果数据访问大大失衡,客户端可能会尝试访问数据服务器。 在这种情况下,禁用单跳并通过不托管数据的服务器可能会更快。

配置客户端对服务器分区区域的单跳访问

配置客户端/服务器系统,以便直接,单跳访问服务器中的分区区域数据。

这需要在服务器上使用一个或多个分区区域的客户端/服务器安装。

- 验证客户端的池属性,未设置

pr-single-hop-enabled或设置为true。 默认情况下是这样。 - 如果可能,将池的

max-connections保留为默认的无限设置(-1)。 - 如果可能,请使用自定义数据解析程序根据客户端的数据使用模式对服务器区域数据进行分区。 请参阅自定义 - 分区您的区域数据. 在客户端的

CLASSPATH中包含服务器的分区解析器实现。 服务器为每个自定义分区区域传递解析程序的名称,因此客户端使用正确的分区。 如果服务器不使用分区解析器,则服务器和客户端之间的默认分区匹配,因此单跳工作。 - 将单跳注意事项添加到整个服务器负载平衡计划中。 单跳使用数据位置而不是最少加载的服务器来选择服务器以进行单键操作。 不均衡的单跳数据访问会影响整体客户端/服务器负载平衡。 一些平衡是自动完成的,因为具有更多单键操作的服务器变得更加负载,并且不太可能被挑选用于其他操作。

重新平衡分区区域数据

在对成员读取或更新并发线程的争用最小的群集中,您可以使用重新平衡来动态增加或减少数据和处理容量。

重新平衡是一项成员操作。 它会影响成员定义的所有分区区域,无论成员是否承载区域的数据。 重新平衡操作执行两项任务:

- 如果不满足配置的分区区域冗余,则重新平衡会尽其所能来恢复冗余。 请参见为分区区域配置高可用性.

- 重新平衡根据需要在主机成员之间移动分区区域数据桶,以在集群中建立最公平的数据和行为平衡。

为了提高效率,在启动多个成员时,在添加所有成员后,一次触发重新平衡。

注意: 如果您的系统中正在运行事务,请务必规划重新平衡操作。 重新平衡可能会在成员之间移动数据,这可能会导致正在运行的事务失败并出现TransactionDataRebalancedException。 修复了自定义分区,完全阻止了重新平衡。 除非您在不同时间运行事务和重新平衡操作,否则所有其他数据分区策略都允许重新平衡并导致此异常。

使用以下方法之一启动重新平衡:

gfsh命令。 首先,启动gfsh提示并连接到集群。 然后键入以下命令:gfsh>rebalance(可选)您可以指定要在重新平衡中包含或排除的区域,为重新平衡操作指定超时或仅模拟重新平衡操作. 输入

help rebalance或查看rebalance 以获取更多信息。API 调用:

ResourceManager manager = cache.getResourceManager(); RebalanceOperation op = manager.createRebalanceFactory().start(); //Wait until the rebalance is complete and then get the results RebalanceResults results = op.getResults(); //These are some of the details we can get about the run from the API System.out.println("Took " + results.getTotalTime() + " milliseconds\n"); System.out.println("Transfered " + results.getTotalBucketTransferBytes()+ "bytes\n");

您还可以通过API模拟重新平衡,以查看是否值得运行:

ResourceManager manager = cache.getResourceManager();

RebalanceOperation op = manager.createRebalanceFactory().simulate();

RebalanceResults results = op.getResults();

System.out.println("Rebalance would transfer " + results.getTotalBucketTransferBytes() +" bytes ");

System.out.println(" and create " + results.getTotalBucketCreatesCompleted() + " buckets.\n");

分区区域重新平衡的工作原理

重新平衡操作以异步方式运行。

默认情况下,一次在一个分区区域上执行重新平衡。 对于具有共处置数据的区域,重新平衡作为一个组在区域上工作,维护区域之间的数据共置。

您可以选择通过设置gemfire.resource.manager.threads系统属性来并行重新平衡多个区域。 将此属性设置为大于1的值可使Geode在使用API启动重新平衡操作时并行重新平衡多个区域。

在重新平衡正在进行时,您可以继续正常使用分区区域。 数据移动时,继续执行读操作,写操作和函数执行。 如果函数正在本地数据集上执行,则在函数执行期间,如果该数据移动到另一个主机,则可能会出现性能下降。 将来的函数调用将路由到正确的成员。

Geode尝试确保每个成员具有与每个分区区域相同的可用空间百分比。 百分比在partition-attributes和local-max-memory设置中配置。

分区重新平衡:

- 除非通过溢出到磁盘启用LRU驱逐,否则不允许超出

local-max-memory设置。 - 尽可能将同一存储桶的多个副本放在不同的主机IP地址上。

- 在存储桶迁移期间重置实时和空闲时间统计信息的输入时间。

- 替换离线成员。

何时重新平衡分区区域

您通常希望在成员启动,关闭或失败时增加或减少容量时触发重新平衡。

您可能还需要在以下时间重新平衡:

- 您使用冗余实现高可用性,并将您的区域配置为在丢失后不自动恢复冗余。 在这种情况下,Geode仅在您调用重新平衡时恢复冗余。 请参见为分区区域配置高可用性.

- 您有不均匀的数据散列。 如果您的key没有哈希代码方法(确保均匀分布),或者如果使用

PartitionResolver来分配分区区域数据(请参阅来自不同分区区域的共存数据),则可能会出现不均匀的哈希。在任何一种情况下,一些桶可能比其他桶接收更多数据。 通过在托管大型存储桶的成员上放置更少的存储桶,可以使用重新平衡来平衡数据存储之间的负载。

如何模拟区域重新平衡

您可以通过使用以下选项执行rebalance命令来移动任何实际数据之前模拟重新平衡操作:

gfsh>rebalance --simulate

注意: 如果您使用heap_lru进行数据驱逐,您可能会注意到模拟结果与实际重新平衡结果之间存在差异。 这种差异可能是由于VM在您执行模拟后开始逐出条目。 然后,当您执行实际的重新平衡操作时,操作将根据较新的堆大小做出不同的决定。

自动重新平衡

实验自动重新平衡功能 会根据时间表触发重新平衡操作。

检查分区中的冗余

在某些情况下,验证分区区域数据是否为冗余并且在成员重新启动时,已跨分区区域成员正确恢复冗余非常重要。

您可以通过确保所有分区区域的numBucketsWithoutRedundancy统计数值为零来验证分区区域冗余。 要检查此统计信息,请使用以下gfsh命令:

gfsh>show metrics --categories=partition --region=region_name

例如:

gfsh>show metrics --categories=partition --region=posts

Cluster-wide Region Metrics

--------- | --------------------------- | -----

partition | putLocalRate | 0

| putRemoteRate | 0

| putRemoteLatency | 0

| putRemoteAvgLatency | 0

| bucketCount | 1

| primaryBucketCount | 1

| numBucketsWithoutRedundancy | 1

| minBucketSize | 1

| maxBucketSize | 0

| totalBucketSize | 1

| averageBucketSize | 1

如果为分区区域配置了start-recovery-delay=-1,则需要在重新启动群集中的任何成员后对区域执行重新平衡,以便恢复冗余。

如果将start-recovery-delay设置为较低的数字,则可能需要等待额外的时间,直到该区域恢复冗余。

将分区区域数据移动到另一个成员

您可以使用PartitionRegionHelper moveBucketByKey和moveData方法将分区区域数据从一个成员显式移动到另一个成员。

moveBucketByKey方法将包含指定键的存储桶从源成员移动到目标成员。 例如,您可以使用该方法将流行的产品项移动到新的空成员,以减少源成员的负载。

例如:

Object product = ...

Region r = ...

DistributedSystem ds = ...

String memberName = ...

//Find the member that is currently hosting the product.

Set<DistributedMember> sourceMembers =

PartitionRegionHelper.getAllMembersForKey(r, product);

//Find the member to move the product to.

DistributedMember destination = ds.findDistributedMember(memberName);

//In this example we assume there is always at least one source.

//In practice, you should check that at least one source

//for the data is available.

source = sourceMembers.iterator().next();

//Move the bucket to the new node. The bucket will

//be moved when this method completes. It throws an exception

//if there is a problem or invalid arguments.

PartitionRegionHelper.moveBucketByKey(r, source, destination, product);

有关更多详细信息,请参阅org.apache.geode.cache.partition.PartitionRegionHelper.moveBucketByKey的Java API文档。

moveData方法将数据从源成员移动到目标成员的给定百分比(以字节为单位)。 例如,您可以使用此方法将指定百分比的数据从重载成员移动到另一个成员以改进分发。

例如:

Region r = ...

DistributedSystem ds = ...

String sourceName = ...

String destName = ...

//Find the source member.

DistributedMember source = ds.findDistributedMember(sourceName);

DistributedMember destination = ds.findDistributedMember(destName);

//Move up to 20% of the data from the source to the destination node.

PartitionRegionHelper.moveData(r, source, destination, 20);

有关更多详细信息,请参阅org.apache.geode.cache.partition.PartitionRegionHelper.moveData的Java API文档。

有关分区区域和重新平衡的更多信息,请参阅分区区域.

分布式和复制区域

除基本区域管理外,分布式和复制区域还包括推送和分配模型,全局锁定和区域条目版本等选项,以确保Geode成员之间的一致性。

分布式如何运作

要使用分布式和复制区域,您应该了解它们的工作方式以及管理它们的选项。

区域分布选项

您可以使用包含和不包含确认的分发,或使用区域分布的全局锁定。 配置为通过确认分发的区域也可以配置为在托管该区域的所有Geode成员之间一致地解析并发更新。

复制和预加载的工作原理

要使用复制和预加载区域,您应该了解如何在缓存中初始化和维护其数据。

配置分布式,复制和预加载区域

规划分布式,复制和预加载区域的配置和持续管理,并配置区域。

锁定全局区域

在全局区域中,系统在更新期间锁定条目和区域。 您还可以根据应用程序的需要显式锁定区域及其条目。 锁定包括系统设置,可帮助您优化性能并锁定成员之间的行为。

分布式如何运作

要使用分布式和复制区域,您应该了解它们的工作方式以及管理它们的选项。

注意: 复制和分布式区域的管理补充了基本配置和编程中提供的用于管理数据区域的一般信息。 另请参见org.apache.geode.cache.PartitionAttributes。

分布式区域自动将条目值更新发送到远程高速缓存并从它们接收更新。

- 分布式条目更新来自

Regionput和create操作(具有非null值的条目的创建被视为已经具有条目key的远程缓存的更新)。 条目更新是有选择地分发的 - 仅限于已定义条目key的高速缓存。 与您通过复制获得的推送模型相比,这提供了拉动模型。 - 仅分发不会导致从远程缓存复制新条目。

- 分布式区域跨群集共享缓存加载器和缓存编写器应用程序事件处理程序插件。

在分布式区域中,新的和更新的条目值会自动分发到已定义条目的远程缓存中。

步骤 1: 应用程序更新或创建条目。 此时,M1缓存中的条目可能尚不存在。

步骤 2: 新值自动分发给持有条目的缓存。

步骤 3: 整个群集中条目的值相同。

区域分布式选项

您可以使用包含和不包含确认的分发,或使用区域分布的全局锁定。 配置为通过确认分发的区域也可以配置为在托管该区域的所有Geode成员之间一致地解析并发更新。

每个分布式区域必须在整个群集中具有相同的范围和并发检查设置。

分布式范围分为三个级别:

distributed-no-ack. 分发操作返回时无需等待其他缓存的响应。 此范围提供最佳性能并使用最少的开销,但它也最容易出现由网络问题引起的不一致。 例如,网络传输层的临时中断可能导致在将更新分发到远程机器上的缓存时失败,同时本地缓存继续更新。

distributed-ack. 发布在继续之前等待来自其他缓存的确认。 这比

distributed-no-ack慢,但涵盖了简单的通信问题,例如临时网络中断。在存在许多

distributed-no-ack操作的系统中,distributed-ack操作可能需要很长时间才能完成。 群集具有可配置的时间,等待对任何distributed-ack消息的确认,然后向日志发送有关无响应成员可能出现的问题的警报。 无论等待多长时间,发送方都会等待以遵守分布式ack区域设置。 管理它的gemfire.properties属性是ack-wait-threshold。global. 在分发操作期间,条目和区域会在群集中自动锁定。 对区域及其条目的所有加载,创建,放置,无效和销毁操作都使用分布式锁执行。 全局范围在整个集群中实施严格一致性,但它是实现一致性的最慢机制。 除了分发操作执行的隐式锁定之外,还可以通过应用程序API显式锁定具有全局范围及其内容的区域。 这允许应用程序对区域和区域条目执行原子,多步操作。

复制和预加载的工作原理

要使用复制和预加载区域,您应该了解如何在缓存中初始化和维护其数据。

通过使用REPLICATE区域快捷方式设置之一,或通过将region属性data-policy设置为replicate,persistent-replicate或preloaded来配置复制和预加载区域。

复制和预加载区域的初始化

在区域创建时,系统使用可以找到的最完整和最新的数据集初始化预加载或复制的区域。 系统使用这些数据源按照此优先顺序初始化新区域:

- 另一个已在集群中定义的复制区域。

- 仅用于持久复制。 磁盘文件,后跟分布式缓存中区域的所有副本的并集。

- 仅适用于预加载区域。 另一个已在集群中定义的预加载区域。

- 分布式缓存中区域的所有副本的并集。

在从复制或预加载区域初始化区域时,如果源区域崩溃,则初始化将重新开始。

如果区域联合用于初始化,如图所示,并且其中一个单独的源区域在初始化期间消失(由于缓存关闭,成员崩溃或区域破坏),新区域可能包含部分数据集 来自坠毁的源区域。 发生这种情况时,不会记录任何警告或抛出异常。 新区域仍然有一整套剩余的成员区域。

初始化后复制和预加载区域的行为

初始化后,预加载区域的操作类似于具有normal和data-policy数据策略的区域,仅接收它在本地缓存中定义的条目的分布。

如果区域配置为复制区域,则它将从其他成员接收分布式区域中的所有新创建。 这是推送分发模型。 与预加载区域不同,复制区域具有一个契约,表明它将保存分布式区域中任何位置的所有条目。

配置分布式,复制和预加载区域

规划分布式,复制和预加载区域的配置和持续管理,并配置区域。

在开始之前,请了解基本配置和编程.

选择与您的区域配置最匹配的区域快捷方式设置。 请参阅 org.apache.geode.cache.RegionShortcut 或Region Shortcuts. 要创建复制区域,请使用

REPLICATE快捷方式设置之一。 要创建预加载区域,请将您的区域data-policy设置为preloaded。 这个cache.xml声明创建了一个复制区域:<region-attributes refid="REPLICATE"> </region-attributes>您还可以使用gfsh配置区域。 例如:

gfsh>create region --name=regionA --type=REPLICATE参见区域类型.

选择您所在地区的分布式级别。

RegionShortcut中分布式区域的区域快捷方式使用distributed-ack范围。 如果需要不同的范围,请将region-attributesscope设置为distributed-no-ack或global。例子:

<region-attributes refid="REPLICATE" scope="distributed-no-ack"> </region-attributes>如果您使用

distributed-ack范围,则可以选择启用该区域的并发检查。例子:

<region-attributes refid="REPLICATE" scope="distributed-ack" concurrency-checks-enabled="true"> </region-attributes>如果您正在使用

global范围,除了Geode提供的自动锁定外,还需要编程您需要的任何显式锁定。

复制区域中的本地销毁和无效

在仅影响本地缓存的所有操作中,在复制区域中仅允许本地区域销毁。 其他操作不可配置或抛出异常。 例如,您不能将本地destroy用作复制区域上的到期操作。 这是因为诸如条目失效和破坏之类的本地操作仅从本地缓存中删除数据。 如果数据在本地删除但保持不变,则复制区域将不再完整。

锁定全局区域

在全局区域中,系统在更新期间锁定条目和区域。 您还可以根据应用程序的需要显式锁定区域及其条目。 锁定包括系统设置,可帮助您优化性能并锁定成员之间的行为。

在具有全局范围的区域中,锁定有助于确保缓存一致性

区域和条目的锁定有两种方式:

Implicit(隐式). Geode在大多数操作期间自动锁定全局区域及其数据条目。 区域失效和销毁不会获取锁定。

Explicit(明确). 您可以使用API显式锁定区域及其条目。 这样做是为了保证具有多步分布式操作的任务的原子性。

Region方法org.apache.geode.cache.Region.getDistributedLock和org.apache.geode.cache.Region.getRegionDistributedLock为区域和指定的键返回java.util.concurrent.locks.Lock的实例。注意: 您必须使用

RegionAPI来锁定区域和区域条目。 不要在org.apache.geode.distributed包中使用DistributedLockService。 该服务仅适用于锁定任意分布式应用程序。 它与Region的locking方法不兼容。

锁定超时

获取区域或条目的锁定是获取实体的锁定实例然后使用实例设置锁定的两步过程。 锁定后,持有它进行操作,然后将其释放给其他人使用。 您可以设置等待获取锁定所花费的时间限制以及持有锁定所花费的时间。 隐式和显式锁定操作都受超时影响:

锁定超时限制等待获取锁定。 缓存属性

lock-timeout控制隐式锁请求。 对于显式锁定,通过调用从RegionAPI返回的java.util.concurrent.locks.Lock实例来指定等待时间。 您可以等待一段特定的时间,无论是否有锁,都可以立即返回,或者无限期地等待。<cache lock-timeout="60"> </cache>gfsh:

gfsh>alter runtime --lock-timeout=60锁定租约限制锁定在自动释放之前可以保持多长时间。 定时锁允许应用程序在成员未能在租用时间内释放获得的锁时进行恢复。 对于所有锁定,此超时使用缓存属性

lock-lease设置。<cache lock-lease="120"> </cache>gfsh:

gfsh>alter runtime --lock-lease=120

优化锁定性能

对于每个全局区域,将为已定义区域的成员之一分配锁定授予者的作业。 锁定授予者运行锁定服务,该服务接收来自系统成员的锁定请求,根据需要对它们进行排队,并按接收的顺序授予它们。

锁定授予者比其他成员略有优势,因为它是唯一一个不必发送消息来请求锁定的成员。 出于同样的原因,设保人的要求成本最低。 因此,您可以通过将锁定授予者状态分配给获取最多锁定的成员来优化区域中的锁定。 这可能是执行最多put的成员,因此需要最隐式锁,或者这可能是执行许多显式锁的成员。

锁定授予者分配如下:

- 任何具有区域定义的成员都会为其分配请求锁定授予者状态。 因此,在任何时候,发出请求的最新成员是锁定授予者。

- 如果没有成员请求区域的锁定授予者状态,或者当前锁定授予者消失,则系统从具有在其高速缓存中定义的区域的成员分配锁定授予者。

您可以申请锁定设备状态:

- 在区域创建时通过

is-lock-grantor属性。 您可以通过region方法getAttributes检索此属性,以查看您是否要求成为该区域的锁定授予者。 注意: 区域创建后,is-lock-grantor属性不会更改。 - 通过区域

becomeLockGrantor方法创建区域后。 但是,应该谨慎地更改锁定授予者,因为这样做需要从其他操作开始循环。 特别是,要小心避免创建一个成员争夺锁定授予者状态的情况。

例子

这两个示例显示了条目锁定和解锁。 注意如何获取条目的Lock对象,然后调用其锁定方法来实际设置锁。 示例程序将条目锁定信息存储在哈希表中以供将来参考。

/* Lock a data entry */

HashMap lockedItemsMap = new HashMap();

...

String entryKey = ...

if (!lockedItemsMap.containsKey(entryKey))

{

Lock lock = this.currRegion.getDistributedLock(entryKey);

lock.lock();

lockedItemsMap.put(name, lock);

}

...

/* Unlock a data entry */

String entryKey = ...

if (lockedItemsMap.containsKey(entryKey))

{

Lock lock = (Lock) lockedItemsMap.remove(name);

lock.unlock();

}

区域更新的一致性

Geode确保区域的所有副本最终在托管该区域的所有成员和客户端上达到一致状态,包括分发区域事件的Geode成员。

按地区类型检查一致性

Geode根据您配置的区域类型执行不同的一致性检查。

配置一致性检查

Geode默认启用一致性检查。 您无法禁用持久性区域的一致性检查。 对于所有其他区域,您可以通过将

cache.xml中的concurrency-checks-enabled区域属性设置为“true”或“false”来显式启用或禁用一致性检查。一致性检查的开销

一致性检查需要额外的开销来存储和分发版本和时间戳信息,以及在一段时间内维护销毁的条目以满足一致性要求。

一致性检查如何适用于复制区域

每个区域都存储用于冲突检测的版本和时间戳信息。 在应用分布式更新之前,Geode成员使用记录的信息一致地检测和解决冲突。

如何解决Destroy和Clear操作

为区域启用一致性检查时,当应用程序销毁该条目时,Geode成员不会立即从该区域中删除条目。 相反,成员将条目保留其当前版本标记一段时间,以便检测可能与已发生的操作发生冲突。 保留的条目称为墓碑。 为了提供一致性,Geode保留了分区区域和非复制区域以及复制区域的逻辑删除。

具有一致性区域的事务

修改启用了一致性检查的区域的事务会在事务提交时生成区域更新的所有必要版本信息。

按地区类型检查一致性

Geode根据您配置的区域类型执行不同的一致性检查。

分区区域的一致性

对于分区区域,Geode通过将给定key上的所有更新路由到保存该key主副本的Geode成员来维护一致性。 该成员持有对key的锁定,同时将更新分发给承载key副本的其他成员。 由于分区区域的所有更新都在主要Geode成员上序列化,因此所有成员都以相同的顺序应用更新,并始终保持一致性。 请参阅了解分区.

复制区域一致性

对于复制区域,托管该区域的任何成员都可以更新key并将该更新分发给其他成员,而无需锁定key。 两个成员可能同时更新相同的key(并发更新)。 由于网络等待时间,一个成员的更新也可能在稍后时间分配给其他成员,之后这些成员已经对key应用了更新的更新(无序更新)。 默认情况下,Geode成员在应用区域更新之前执行冲突检查,以便检测并一致地解决并发和无序更新。 冲突检查可确保区域数据最终在托管该区域的所有成员上保持一致。 复制区域的冲突检查行为总结如下:

- 如果两个成员同时更新同一个key,则冲突检查会确保所有成员最终应用相同的值,即两个并发更新之一的值。

- 如果成员收到无序更新(在应用一个或多个最新更新后收到的更新),则冲突检查可确保丢弃无序更新,而不应用于缓存。

一致性检查如何适用于复制区域 和 如何解决Destroy和Clear操作 提供有关Geode在应用更新时如何执行冲突检查的更多详细信息。

非复制区域和客户端缓存一致性

当成员收到非复制区域中的条目的更新并应用更新时,它将以与复制区域相同的方式执行冲突检查。 但是,如果成员对区域中不存在的条目启动操作,则它首先将该操作传递给承载复制的成员。 承载副本的成员生成并提供后续冲突检查所需的版本信息。 请参见一致性检查如何为复制区域工作.

客户端缓存在收到区域条目的更新时也以相同的方式执行一致性检查。 但是,首先将源自客户端缓存的所有区域操作传递到可用的Geode服务器,该服务器生成后续冲突检查所需的版本信息。

配置一致性检查

Geode默认启用一致性检查。 您无法禁用持久性区域的一致性检查。 对于所有其他区域,您可以通过将cache.xml中的concurrency-checks-enabled 区域属性设置为“true”或“false”来显式启用或禁用一致性检查。

承载区域的所有Geode成员必须对该区域使用相同的concurrency-checks-enabled设置。

即使服务器缓存启用了对同一区域的一致性检查,客户端缓存也可以禁用区域的一致性检查。 此配置可确保客户端查看该区域的所有事件,但不会阻止客户端缓存区域与服务器缓存不同步。

注意: 不启用一致性检查的区域仍然受竞争条件的影响。 并发更新可能导致一个或多个成员具有相同key的不同值。 网络延迟可能导致在发生更新后将旧更新应用于key。

一致性检查的开销

一致性检查需要额外的开销来存储和分发版本和时间戳信息,以及在一段时间内维护销毁的条目以满足一致性要求。

为了提供一致性检查,每个区域条目使用额外的16个字节。 删除条目时,会创建并维护大约13个字节的逻辑删除条目,直到逻辑删除过期或在成员中进行垃圾收集。 (当一个条目被销毁时,该成员临时保留该条目及其当前版本标记,以检测可能与已发生的操作的冲突。保留的条目称为墓碑。)参见如何解决销毁和清除操作.

如果您无法支持部署中的额外开销,则可以通过为每个区域设置concurrency-checks-enabled为“false”来禁用一致性检查。 请参阅区域更新的一致性.

一致性检查如何适用于复制区域

每个区域都存储用于冲突检测的版本和时间戳信息。 在应用分布式更新之前,Geode成员使用记录的信息一致地检测和解决冲突。

默认情况下,区域中的每个条目都存储上次更新条目的Geode成员的ID,以及每次更新发生时递增的条目的版本标记。 版本信息存储在每个本地条目中,并且在更新本地条目时将版本标记分发给其他Geode成员。

接收更新消息的Geode成员或客户端首先将更新版本标记与其本地高速缓存中记录的版本标记进行比较。 如果更新版本标记较大,则表示该条目的较新版本,因此接收成员在本地应用更新并更新版本信息。 较小的更新版本标记表示无序更新,将被丢弃。

相同的版本标记表示多个Geode成员同时更新了相同的条目。 要解决并发更新,Geode成员始终应用(或保留)具有最高成员身份ID的区域条目; 具有较低成员资格ID的区域条目被丢弃。

注意: 当Geode成员丢弃更新消息时(无论是无序更新还是解析并发更新),它都不会将丢弃的事件传递给该区域的事件侦听器。 您可以使用conflatedEvents统计信息跟踪每个成员的丢弃更新数。 参见Geode统计列表. 某些成员可能会在其他成员应用更新时丢弃更新,具体取决于每个成员收到更新的顺序。 因此,每个Geode成员的conflatedEvents统计信息都不同。 以下示例更详细地描述了此行为。

以下示例显示如何在三个Geode成员的集群中处理并发更新。 假设成员A,B和C的成员资格ID分别为1,2和3。 每个成员当前在其版本C2的缓存中存储条目X(该条目最后由成员C更新):

步骤 1: 应用程序更新Geode成员A上的条目X,同时另一个应用程序更新成员C上的条目X.每个成员递增条目的版本标记,并在其本地缓存中记录带有其成员标识的版本标记。 在这种情况下,条目最初是在C2版本,因此每个成员在其本地缓存中将版本更新为3(分别为A3和C3)。

步骤 2: 成员A将其更新消息分发给成员B和C.

成员B将更新版本标记(3)与其记录的版本标记(2)进行比较,并将更新作为版本A3应用于其本地高速缓存。 在此成员中,更新将暂时应用,并传递给已配置的事件侦听器。

成员C将更新版本标记(3)与其记录的版本标记(3)进行比较,并标识并发更新。 为解决冲突,成员C接下来将更新的成员身份ID与存储在其本地缓存中的成员身份ID进行比较。 因为更新(A3)的分布式系统ID低于存储在高速缓存(C3)中的ID,所以成员C丢弃更新(并增加conflatedEvents统计信息)。

步骤 3: 成员C将更新消息分发给成员A和B.

成员A和B将更新版本标记(3)与其记录的版本标记(3)进行比较,并识别并发更新。 为了解决冲突,两个成员都将更新的成员身份ID与存储在其本地缓存中的成员身份ID进行比较。 由于缓存值中A的分布式系统ID小于更新中的C的ID,因此两个成员都会在其本地缓存中记录更新C3,从而覆盖先前的值。

此时,托管该区域的所有成员都已成为成员A和C上的并发更新的一致状态。

如何解决Destroy和Clear操作

为区域启用一致性检查时,当应用程序销毁该条目时,Geode成员不会立即从该区域中删除条目。 相反,成员将条目保留其当前版本标记一段时间,以便检测可能与已发生的操作发生冲突。 保留的条目称为墓碑。 为了提供一致性,Geode保留了分区区域和非复制区域以及复制区域的逻辑删除。

客户端缓存或非复制区域中的逻辑删除在8分钟后到期,此时逻辑删除立即从缓存中删除。

复制或分区区域的墓碑在10分钟后到期。 过期的墓碑有资格由Geode成员进行垃圾收集。 任何类型的100,000个墓碑在本地Geode成员中超时后,将自动触发垃圾收集。 您可以选择将gemfire.tombstone-gc-threshold属性设置为小于100000的值,以更频繁地执行垃圾回收。

注意: 为了避免内存不足错误,当可用内存量低于总内存的30%时,Geode成员还会启动逻辑删除的垃圾回收。

您可以使用CachePerfStats中的tombstoneCount统计信息来监视缓存中的逻辑删除总数。 tombstoneGCCount统计信息记录成员执行的逻辑删除垃圾收集周期的总数。 replicatedTombstonesSize和nonReplicatedTombstonesSize分别显示复制或分区区域和非复制区域中墓碑当前消耗的大致字节数。 参见Geode统计列表.

关于Region.clear()操作

区域条目版本标记和逻辑删除仅在单个条目被销毁时确保一致性。 但是,Region.clear()操作一次对区域中的所有条目进行操作。 为了为Region.clear()操作提供一致性,Geode获得该区域的分布式读/写锁,该锁阻止对该区域的所有并发更新。 在清除区域之前允许在清除操作之前启动的任何更新。

具有一致性区域的事务

修改启用了一致性检查的区域的事务会在事务提交时生成区域更新的所有必要版本信息。

如果事务修改了正常区域,预加载区域或空区域,则事务首先委托给保存区域复制的Geode成员。 此行为类似于分区区域的事务行为,其中分区区域事务将转发到承载分区区域更新主节点的成员。

正常,预加载或空区域上的事务限制是,当启用一致性检查时,事务不能对该区域执行localDestroy或localInvalidate操作。 在这种情况下,Geode会抛出UnsupportedOperationInTransactionException异常。 当启用一致性检查时,应用程序应使用Destroy或Invalidate操作代替localDestroy或localInvalidate。

一般地区数据管理

对于所有区域,您可以选择控制内存使用,将数据备份到磁盘,以及从缓存中丢弃过时数据。

Persistence and Overflow(持久性和溢出)

您可以将数据保留在磁盘上以进行备份,并将其溢出到磁盘以释放内存,而无需从缓存中完全删除数据。

Eviction(驱逐)

使用逐出来控制数据区域大小。 驱逐行动由基于空间的阈值触发。

Expiration(到期)

使用到期可以保持数据最新并通过删除过时条目来减小区域大小。 到期操作由基于时间的阈值触发。

保持缓存与外部数据源同步

通过编程和安装适用于您所在地区的应用程序插件,使分布式缓存与外部数据源保持同步。

Persistence and Overflow(持久性和溢出)

您可以将数据保留在磁盘上以进行备份,并将其溢出到磁盘以释放内存,而无需从缓存中完全删除数据。

注意: 这补充了基本配置和编程中提供的管理数据区域的一般步骤.

所有磁盘存储都使用Apache Geode 磁盘存储.

持久性和溢出如何工作

要使用Geode持久性和溢出,您应该了解它们如何处理您的数据。

配置区域持久性和溢出

计划数据区域的持久性和溢出并相应地进行配置。

溢出配置示例

cache.xml示例显示了区域和服务器订阅队列溢出的配置。

持久性和溢出如何工作

要使用Geode持久性和溢出,您应该了解它们如何处理您的数据。

Geode持续存在并溢出了几种类型的数据。 您可以保留或溢出您所在地区的应用程序数据。 此外,Geode持续存在并溢出消息队列,以管理内存消耗并提供高可用性。

持久性数据比区域所在的成员更长,并且可用于在创建时初始化区域。 溢出仅作为内存中区域的扩展。

根据Geode磁盘存储的配置将数据写入磁盘。 对于任何磁盘选项,您可以指定要使用的磁盘存储的名称或使用Geode默认磁盘存储。 参见磁盘存储.

数据如何保持和溢出

对于持久性,将条目键和值复制到磁盘。 对于溢出,仅复制条目值。 其他数据(如统计信息和用户属性)仅保留在内存中。

- 数据区域通过最近最少使用(LRU)条目溢出到磁盘,因为这些条目被认为是应用程序最不感兴趣的,因此不太可能被访问。

- 服务器订阅队列溢出最近使用的(MRU)条目。 这些是位于队列末尾的消息,因此最后排队发送到客户端。

Persistence(持久化)

持久性提供区域条目数据的磁盘备份。 所有条目的键和值都保存到磁盘,就像在磁盘上具有该区域的副本一样。 区域输入操作(如put和destroy)在内存和磁盘上执行。

当成员因任何原因停止时,磁盘上的区域数据仍然存在。 在分区区域中,数据存储区在成员之间划分,这可能导致某些数据仅在磁盘上,某些数据在磁盘上和内存中。 磁盘数据可以在成员启动时使用以填充相同的区域。

Overflow(溢出)

溢出通过将最近最少使用(LRU)条目的值移动到磁盘来限制内存中的区域大小。 溢出基本上使用磁盘作为条目值的交换空间。 如果请求的条目的值仅在磁盘上,则该值将被复制回内存,可能导致将不同LRU条目的值移动到磁盘。 与持久化条目一样,溢出条目在磁盘上维护,就像它们在内存中一样。

在此图中,条目X的值已移至磁盘以在内存中腾出空间。 X的键仍然在内存中。 从分布式系统的角度来看,磁盘上的值与内存中的数据一样是区域的一部分。

持久性和溢出在一起

一起使用,持久性和溢出将所有条目键和值保留在磁盘上,并且只保留内存中最活跃的条目值。 由于溢出而从内存中删除条目值对磁盘副本没有影响,因为所有条目都已在磁盘上。

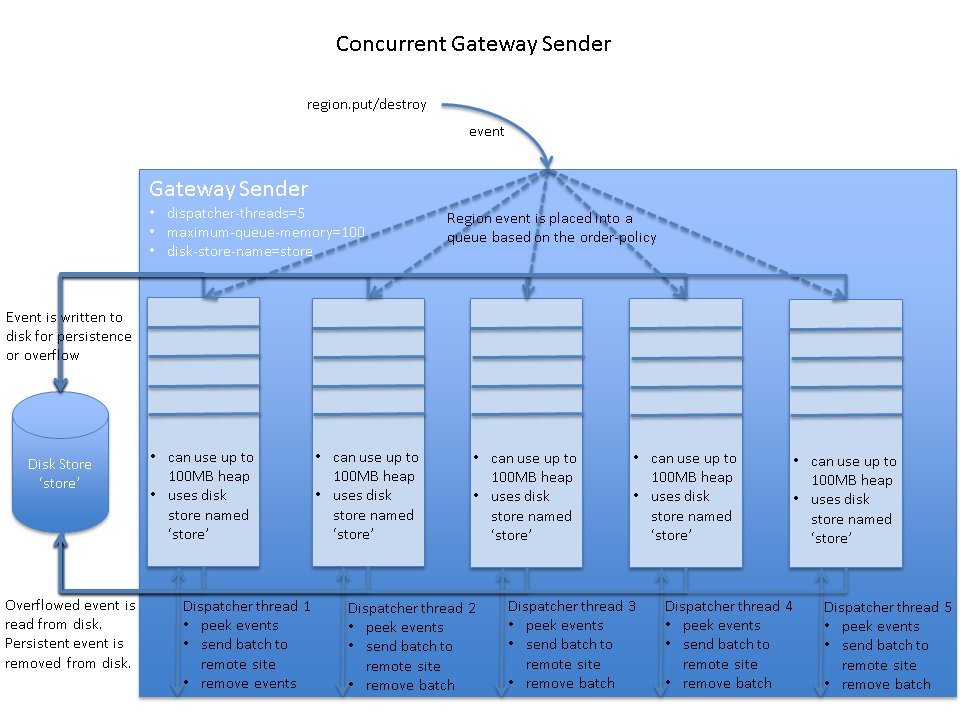

持久性和多站点配置

多站点网关发送方队列溢出最近使用的(MRU)条目。 这些是队列末尾的消息,因此最后排队发送到远程站点。 您还可以配置网关发件人队列以保持高可用性。

配置区域持久性和溢出

计划数据区域的持久性和溢出并相应地进行配置。

使用以下步骤为持久性和溢出配置数据区域:

根据需要配置磁盘存储。 请参阅设计和配置磁盘存储。 缓存磁盘存储区定义数据写入磁盘的位置和方式。

<disk-store name="myPersistentStore" . . . > <disk-store name="myOverflowStore" . . . >指定区域的持久性和溢出条件。 如果未使用默认磁盘存储,请在区域属性配置中提供磁盘存储名称。 要异步写入磁盘,请指定

disk-synchronous=“false”。对于溢出,请在区域的'eviction-attributes`中指定溢出条件,并命名要使用的磁盘存储。

例子:

<region name="overflowRegion" . . . > <region-attributes disk-store-name="myOverflowStore" disk-synchronous="true"> <eviction-attributes> <!-- Overflow to disk when 100 megabytes of data reside in the region --> <lru-memory-size maximum="100" action="overflow-to-disk"/> </eviction-attributes> </region-attributes> </region>gfsh:

你不能使用gfsh配置

lru-memory-size。对于持久性,将

data-policy设置为persistent-replicate并命名要使用的磁盘存储。例子:

<region name="partitioned_region" refid="PARTITION_PERSISTENT"> <region-attributes disk-store-name="myPersistentStore"> . . . </region-attributes> </region>

启动成员时,将使用磁盘存储和磁盘写入行为自动执行溢出和持久性。

注意: 您还可以使用gfsh命令行界面配置区域和磁盘存储。 参见地区命令 和 磁盘存储命令.

| 相关话题 |

|---|

org.apache.geode.cache.RegionAttributes 用于数据区域持久性信息 |

org.apache.geode.cache.EvictionAttributes 用于数据区域溢出信息 |

org.apache.geode.cache.server.ClientSubscriptionConfig |

溢出配置示例

cache.xml示例显示了区域和服务器订阅队列溢出的配置。

根据以下因素之一配置溢出条件:

- 条目计数

- 绝对内存消耗

- 内存消耗占应用程序堆的百分比(不适用于服务器订阅队列)

区域溢出配置:

<!-- Overflow when the region goes over 10000 entries -->

<region-attributes>

<eviction-attributes>

<lru-entry-count maximum="10000" action="overflow-to-disk"/>

</eviction-attributes>

</region-attributes>

服务器客户端订阅队列溢出的配置:

<!-- Overflow the server's subscription queues when the queues reach 1 Mb of memory -->

<cache>

<cache-server>

<client-subscription eviction-policy="mem" capacity="1"/>

</cache-server>

</cache>

Eviction(逐出)

使用逐出来控制数据区域大小。 驱逐行动由基于空间的阈值触发。

逐出如何运作

逐出设置会导致Apache Geode通过删除最近最少使用(LRU)条目来为新条目腾出空间,从而使区域的资源在指定级别下保持使用。

配置数据逐出

配置区域的'eviction-attributes`设置以使您的区域保持在指定的限制内。

驱逐如何运作

驱逐通过删除最近最少使用(LRU)条目来为新条目让路,从而使区域的资源在指定级别下保持使用。 您可以选择过期的条目是溢出到磁盘还是已销毁。 参见持久性和溢出.

当超过基于大小的阈值时触发驱逐。 区域的逐出阈值可以基于:

- 条目计数

- 绝对内存使用量

- 可用堆的百分比

这些驱逐算法是互斥的; 只有一个可以对给定区域有效。

当Geode确定添加或更新条目会使区域超过指定级别时,它会溢出或删除足够的旧条目以腾出空间。 对于条目计数驱逐,这意味着较新条目的一对一交易。 对于内存设置,需要删除以创建空间的旧条目数取决于较旧和较新条目的大小。

为了提高效率,移除物品的选择不是严格的LRU,而是从该地区最古老的条目中选择驱逐候选者。 因此,逐出可能会在本地数据存储中留下该区域的旧条目。

驱逐行动

Apache Geode提供以下驱逐操作:

- 当地销毁 - 从本地缓存中删除条目,但不将删除操作分发给远程成员。 此操作可以应用于分区区域中的条目,但如果启用了冗余(冗余副本> 0),则不建议这样做,因为它会引入冗余存储区之间的不一致。 当应用于复制区域中的条目时,Geode会将区域类型静默更改为

预加载以适应本地修改。 - 溢出到磁盘 - 条目的值溢出到磁盘并在内存中设置为null。 条目的key保留在缓存中。 这是分区区域唯一完全支持的驱逐操作。

分区中的驱逐

在分区区域中,Geode会删除正在执行新条目操作的存储桶中可找到的最旧条目。 Geode在逐桶的基础上维护LRU条目信息,因为跨分区区域维护信息的成本会降低系统的性能。

- 对于存储器和入口计数驱逐,LRU驱逐在正在执行新的条目操作的桶中完成,直到成员中的组合桶的总体大小已经下降到足以执行操作而不超过限制。

- 对于堆驱逐,每个分区区域桶被视为它是一个单独的区域,每个驱逐操作仅考虑桶的LRU,而不是整个分区区域。

配置数据驱逐

配置区域的'eviction-attributes`设置以使您的区域保持在指定的限制内。

配置数据驱逐如下。 您无需按所示顺序执行这些步骤。

- 决定是否根据以下方式逐出:

- 条目计数(如果您的条目大小相对均匀,则非常有用)。

- 使用的总字节数。 在分区区域中,使用

local-max-memory设置。 在非分区区域中,它在eviction-attributes中设置。 - 使用的应用程序堆的百分比。 这使用Geode资源管理器。 当管理器确定需要驱逐时,管理器命令驱逐控制器开始从驱逐算法设置为

lru-heap-percentage的所有区域驱逐。 驱逐出去,直到管理器停止。 Geode驱逐该成员为该地区托管的最近最少使用的条目。 请参阅管理堆和堆外内存.

- 确定达到限制时要采取的操作:

- 在本地销毁该条目。

- 将条目数据溢出到磁盘。 参见持久性和溢出.

- 确定成员中允许的最大数据量,用于指示的驱逐测量。 这是成员中区域的所有存储的最大值。 对于分区区域,这是存储在区域成员中的所有存储区的总数,包括用于冗余的任何辅助存储区。

- 决定是否为您所在的地区编制自定义sizer。 如果您能够提供这样的类,它可能比Geode完成的标准大小更快。 您的自定义类必须遵循定义自定义类的准则,另外,必须实现

org.apache.geode.cache.util.ObjectSizer。 请参见在数据缓存中使用自定义类的要求.

例子:

设置LRU内存驱逐阈值为1000 MB。 使用自定义类来测量区域中每个对象的大小:

gfsh>create region --name=myRegion --type=REPLICATE --eviction-max-memory=1000 \

--eviction-action=overflow-to-disk --eviction-object-sizer=com.myLib.MySizer

在分区区域上创建逐出阈值,最大条目数为512:

gfsh>create region --name=myRegion --type=PARTITION --eviction-entry-count=512 \

--eviction-action=overflow-to-disk

要为堆LRU驱逐配置分区区域,首先在服务器启动时配置资源管理器,然后创建启用了驱逐的区域:

gfsh>start server --name=Server1 --eviction-heap-percentage=80

...

gfsh>create region --name=myRegion --type=PARTITION --eviction-action=overflow-to-disk

Expiration(到期)

使用到期可以保持数据最新并通过删除过时条目来减小区域大小。 到期操作由基于时间的阈值触发。

过期如何运作

到期删除您未使用的旧条目和条目。 您可以选择是否使过期的条目失效或销毁。

配置数据过期

配置到期类型和要使用的到期操作。

过期如何运作

到期通过删除您未使用的旧条目和条目来保持区域数据的新鲜。 您可以选择是否使过期的条目失效或销毁。

分布式区域中的过期活动可以是分布式的或本地的。 因此,一个高速缓存可以控制系统中的多个高速缓存的到期。

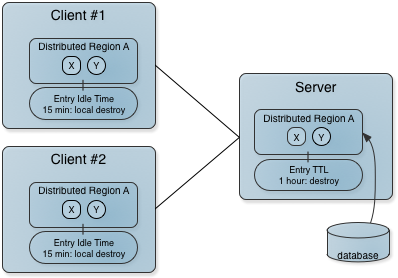

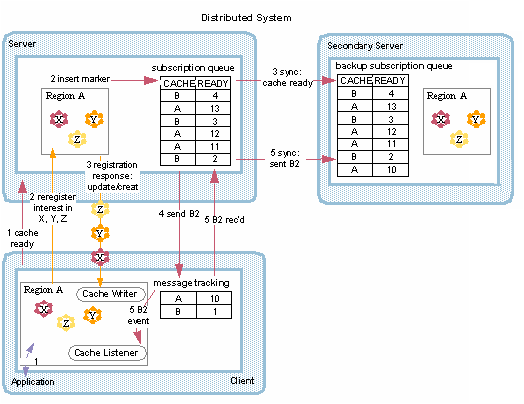

此图显示了客户端/服务器系统的两个基本过期设置。 服务器(右侧)从数据库填充区域,数据自动分布在整个系统中。 数据仅在一小时内有效,因此服务器对一小时的条目执行分布式销毁。 客户端应用程序是消费者。 客户端通过删除没有本地利益的条目的本地副本(空闲时间到期)来释放其缓存中的空间。 对客户端已过期的条目的请求将转发到服务器。

到期类型

Apache Geode提供两种类型的到期,每种类型都由基于时间的阈值触发。 这些可以共存; 它们不是相互排斥的。

- Time to live (TTL). 在上次创建或更新后,对象可能保留在缓存中的时间量(以秒为单位)。 对于条目,对于创建和放置操作,计数器设置为零。 创建区域时以及当条目的计数器重置时,区域计数器将复位。 TTL到期属性是

region-time-to-live和entry-time-to-live。 - Idle timeout. 在上次访问后,对象可能保留在缓存中的时间量(以秒为单位)。 只要TTL计数器复位,对象的空闲超时计数器就会复位。 此外,只要通过get操作或netSearch访问条目,就会重置条目的空闲超时计数器。 只要为其中一个条目重置空闲超时,就会重置区域的空闲超时计数器。 空闲超时到期属性是:

region-idle-time和entry-idle-time。

到期行动

Apache Geode提供以下过期操作:

- invalidate (default) - 数据项的值将被删除,但key仍保留在缓存中。 适用于复制数据项的所有分布式成员。

- destroy - 数据项的键和值都被删除。 适用于复制数据项的所有分布式成员。

- local invalidate - 删除数据项的值。 仅适用于本地成员。

- local destroy - 删除数据项的键和值。 仅适用于本地成员。

您不能在复制或分区区域中使用local-destroy或local-invalidate到期操作。 您只能在分布式区域上使用本地选项,其数据策略为空,正常或预加载。

复制区域和分区区域中的条目到期

在复制区域中,条目更新在最方便可用的数据副本中执行,然后复制到其他成员,同时重置其上次更新的统计信息。 在分区区域中,始终在主副本中完成条目更新,重置主副本的上次更新和最后访问的统计信息,然后更新辅助副本以匹配。

在复制区域和分区区域中,条目检索使用最方便的可用数据副本,其可以是任何分布式副本。 检索不会传播给其他成员。 当数据项被考虑到期时,将协调上次访问时间的差异。

如果自上次更新或读取访问后经过的时间超过建立的阈值,则可以在复制区域的任何副本中触发到期。 分区区域中的到期在主副本中执行,基于主要的上次访问和最后更新的统计信息。 在这两种情况下,到期机制都会检查数据项的所有副本的最后访问日期,并将所有副本的最后访问日期更新为最近的最后访问日期。 然后,如果经过的时间仍然使数据项超过到期阈值,则根据为该区域指定的到期动作删除该项。

到期设置和netSearch之间的交互

在netSearch从远程缓存中检索条目值之前,它根据local区域的到期设置验证remote条目的统计信息。 已经过期的本地缓存中的条目将被传递。 验证后,该条目将进入本地缓存,并为本地副本更新本地访问和更新统计信息。 重置最后访问的时间,并将最后修改的时间更新为远程高速缓存中的时间,并对系统时钟差异进行更正。 因此,为本地条目分配了在集群中修改条目的真实最后时间。 netSearch操作对远程缓存中的到期计数器没有影响。

netSearch方法仅在分布式区域上运行,其数据策略为空,正常和预加载。

配置数据过期

配置到期类型和要使用的到期操作。

- 到期操作需要将

statistics-enabled的region属性设置为true。 这可以在cache.xml文件的region元素,gfsh命令行或通过API完成。 - 使用到期类型设置到期属性,包括最大时间和到期操作。 查看区域属性列表中的

entry-time-to-live,entry-idle-time,region-time-to-live和region-idle-time在 .

用于到期的统计信息可通过Region和Region.Entry getStatistics方法返回的CacheStatistics对象直接提供给应用程序。 CacheStatistics对象还提供了重置统计计数器的方法。

对于分区区域:

- 在分区区域上,仅对区域的条目支持到期,而不支持区域本身。 区域范围的到期属性,例如

region-time-to-live和region-idle-time不适用于分区区域中的数据项。 - 要在使用分区区域时确保可靠的读取行为,请使用

entry-time-to-live属性,而不是entry-idle-time属性。 - 您不能在分区区域中使用

local-destroy或local-invalidate到期操作。

复制区域示例:

// Setting standard expiration on an entry

<region-attributes statistics-enabled="true">

<entry-idle-time>

<expiration-attributes timeout="60" action="local-invalidate"/>

</entry-idle-time>

</region-attributes>

如果应用程序需要,请覆盖特定条目的区域范围设置。 去做这个:

编写实现

org.apache.geode.cache.CustomExpiry的自定义过期类。 例如:// Custom expiration class // Use the key for a region entry to set entry-specific expiration timeouts of // 10 seconds for even-numbered keys with a DESTROY action on the expired entries // Leave the default region setting for all odd-numbered keys. public class MyClass implements CustomExpiry, Declarable { private static final ExpirationAttributes CUSTOM_EXPIRY = new ExpirationAttributes(10, ExpirationAction.DESTROY); public ExpirationAttributes getExpiry(Entry entry) { int key = (Integer)entry.getKey(); return key % 2 == 0 ? CUSTOM_EXPIRY : null; } }在区域的到期属性设置中定义类。 例如:

<!-- Set default entry idle timeout expiration for the region --> <!-- Pass entries to custom expiry class for expiration overrides --> <region-attributes statistics-enabled="true"> <entry-idle-time> <expiration-attributes timeout="60"> <custom-expiry> <class-name>com.company.mypackage.MyClass</class-name> </custom-expiry> </expiration-attributes> </entry-idle-time> </region-attributes>

上述XML的gfsh等价物是:

gfsh> create region --name=region1 --type=REPLICATE --enable-statistics \ --entry-idle-time-expiration=60 --entry-idle-time-custom-expiry=com.company.mypackage.MyClass当主要过期条目时,它会从辅助节点请求最后访问的统计信息。 如果有必要,主要采用最近的访问时间并重新安排到期时间。 这仅针对分布式到期操作执行,并且适用于分区和复制区域。

您还可以使用gfsh命令行界面配置区域。 参见区域命令.

配置到期的线程数

您可以使用gemfire.EXPIRY_THREADS系统属性来增加处理到期的线程数。 默认情况下,一个线程处理到期,当条目到期的速度超过线程可以使它们到期时,线程可能会变得过载。 如果单个线程处理过多的过期,则可能导致OOME。 启动缓存服务器时,将gemfire.EXPIRY_THREADS系统属性设置为所需的数字。

保持缓存与外部数据源同步

通过编程和安装适用于您所在地区的应用程序插件,使分布式缓存与外部数据源保持同步。

外部数据源概述

Apache Geode具有应用程序插件,可将数据读入缓存并将其写出。

使用JNDI配置数据库连接.

使用JNDI维护包含外部数据源的连接池。

数据加载器的工作原理

默认情况下,区域没有定义数据加载器。 通过在托管区域数据的成员上设置region属性cache-loader,将应用程序定义的加载程序插入任何区域。

实现数据加载器

编程数据加载器并配置您的区域以使用它。

外部数据源概述

Apache Geode具有应用程序插件,可将数据读入缓存并将其写出。

应用程序插件:

使用

org.apache.geode.cache.CacheLoader的实现加载有关缓存未命中的数据。 当get操作无法在缓存中找到值时,将调用CacheLoader.load方法。 从加载器返回的值被放入缓存并返回到getoperation。 您可以将此与数据到期结合使用以清除旧数据和其他数据加载应用程序,这些应用程序可能由外部数据源中的事件提示。 请参阅配置数据过期.使用缓存事件处理程序

CacheWriter和CacheListener将数据写入数据源。 有关实现的详细信息,请参阅实现缓存事件处理程序.实现缓存事件处理程序

CacheWriter同步运行。 在对区域条目执行任何操作之前,如果为群集中的区域定义了任何缓存编写器,则系统将调用最方便的编写器。 在分区和分布式区域中,缓存编写器通常仅在包含该区域的高速缓存的子集中定义 - 通常仅在一个高速缓存中。 缓存写入器可以中止区域输入操作。CacheListener在更新缓存后同步运行。 此侦听器仅适用于本地缓存事件,因此请将侦听器安装在您希望它处理事件的每个缓存中。 您可以在任何缓存中安装多个缓存侦听器。

除了使用应用程序插件外,还可以在cache.xml中配置外部JNDI数据库源,并在事务中使用这些数据源。 有关详细信息,请参阅使用JNDI配置数据库连接。

使用JNDI配置数据库连接

要连接到外部数据库,例如在使用JTA事务时,可以在cache.xml中配置数据库JNDI数据源。 DataSource对象指向JDBC连接,或者更常见的是JDBC连接池。 连接池通常是首选,因为程序可以根据需要使用和重用连接,然后释放它以供另一个线程使用。

以下列表显示了JTA事务中使用的DataSource连接类型:

- XAPooledDataSource. XA池化SQL连接。

- ManagedDataSource. J2EE连接器体系结构(JCA)ManagedConnectionFactory的JNDI绑定类型。

- PooledDataSource. 池化SQL连接。

- SimpleDataSource. 单个SQL连接。 没有完成SQL连接池。 连接是动态生成的,无法重复使用。

jndi-binding元素的jndi-name属性是键绑定参数。 如果jndi-name的值是DataSource,则它被绑定为java:/myDatabase**,其中myDatabase*是您为数据源指定的名称。 如果数据源无法在运行时绑定到JNDI,则Geode会记录警告。 有关DataSource接口的信息,请参阅: http://docs.oracle.com/javase/8/docs/api/javax/sql/DataSource.html

Geode支持JDBC 2.0和3.0。

注意: 在CLASSPATH中包含任何数据源JAR文件。

cache.xml中的示例DataSource配置

以下部分显示为每个DataSource连接类型配置的示例cache.xml文件。

XAPooledDataSource cache.xml示例(Derby)

该示例显示了为连接到数据资源newDB的XAPooledDataSource连接池配置的cache.xml文件。

登录和阻止超时设置低于默认值。 连接信息,包括user-name和password,在cache.xml文件中设置,而不是等到连接时间。 密码未加密。

在为支持XA事务的JCA实现的数据库驱动程序指定配置属性时(换句话说,XAPooledDataSource),必须使用配置属性来定义数据源连接,而不是connection-url元素的<jndi-binding>属性。 配置属性因数据库供应商而异。 通过config-property标记指定JNDI绑定属性,如本例所示。 您可以根据需要添加尽可能多的config-property标签。

<?xml version="1.0" encoding="UTF-8"?>

<cache

xmlns="http://geode.apache.org/schema/cache"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://geode.apache.org/schema/cache http://geode.apache.org/schema/cache/cache-1.0.xsd"

version="1.0"

lock-lease="120" lock-timeout="60" search-timeout="300">

<region name="root">

<region-attributes scope="distributed-no-ack" data-policy="cached" initial-capacity="16"

load-factor="0.75" concurrency-level="16" statistics-enabled="true">

. . .

</region>

<jndi-bindings>

<jndi-binding type="XAPooledDataSource"

jndi-name="newDB2trans"

init-pool-size="20"

max-pool-size="100"

idle-timeout-seconds="20"

blocking-timeout-seconds="5"

login-timeout-seconds="10"

xa-datasource-class="org.apache.derby.jdbc.EmbeddedXADataSource"

user-name="mitul"

password="thecleartextpassword">

<config-property>

<config-property-name>Description</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>pooled_transact</config-property-value>

</config-property>

<config-property>

<config-property-name>DatabaseName</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>newDB</config-property-value>

</config-property>

<config-property>

<config-property-name>CreateDatabase</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>create</config-property-value>

</config-property>

. . .

</jndi-binding>

</jndi-bindings>

</cache>

不同XAPooledDataSource连接的JNDI绑定配置属性

以下是不同数据库的一些示例数据源配置。 有关其他详细信息,请参阅供应商数据库的文档。

MySQL

...

<jndi-bindings>

<jndi-binding type="XAPooledDataSource"

...

xa-datasource-class="com.mysql.jdbc.jdbc2.optional.MysqlXADataSource">

<config-property>

<config-property-name>URL</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>"jdbc:mysql://mysql-servername:3306/databasename"</config-property-value>

</config-property>

...

</jndi-binding>

...

</jndi-bindings>

PostgreSQL

...

<jndi-bindings>

<jndi-binding type="XAPooledDataSource"

...

xa-datasource-class="org.postgresql.xa.PGXADataSource">

<config-property>

<config-property-name>ServerName</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>postgresql-hostname</config-property-value>

</config-property>

<config-property>

<config-property-name>DatabaseName</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>postgresqldbname</config-property-value>

</config-property>

...

</jndi-binding>

...

</jndi-bindings>

Oracle

...

<jndi-bindings>

<jndi-binding type="XAPooledDataSource"

...

xa-datasource-class="oracle.jdbc.xa.client.OracleXADataSource">

<config-property>

<config-property-name>URL</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>jdbc:oracle:oci8:@tc</config-property-value>

</config-property>

...

</jndi-binding>

...

</jndi-bindings>

Microsoft SQL Server

...

<jndi-bindings>

<jndi-binding type="XAPooledDataSource"

...

xa-datasource-class="com.microsoft.sqlserver.jdbc.SQLServerXADataSource">

<config-property>

<config-property-name>ServerName</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>mysqlserver</config-property-value>

</config-property>

<config-property>

<config-property-name>DatabaseName</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>databasename</config-property-value>

</config-property>

<config-property>

<config-property-name>SelectMethod</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>cursor</config-property-value>

</config-property>

...

</jndi-binding>

...

</jndi-bindings>

ManagedDataSource连接示例(Derby)

JCA的ManagedConnectionFactory的ManagedDataSource连接的配置如示例所示。 这种配置类似于XAPooledDataSource连接,除了类型是ManagedDataSource,你指定managed-conn-factory-class而不是xa-datasource-class。

<?xml version="1.0"?>

<cache xmlns="http://geode.apache.org/schema/cache"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://geode.apache.org/schema/cache http://geode.apache.org/schema/cache/cache-1.0.xsd"

version="1.0"

lock-lease="120"

lock-timeout="60"

search-timeout="300">

<region name="root">

<region-attributes scope="distributed-no-ack" data-policy="cached" initial-capacity="16"

load-factor="0.75" concurrency-level="16" statistics-enabled="true">

. . .

</region>

<jndi-bindings>

<jndi-binding type="ManagedDataSource"

jndi-name="DB3managed"

init-pool-size="20"

max-pool-size="100"

idle-timeout-seconds="20"

blocking-timeout-seconds="5"

login-timeout-seconds="10"

managed-conn-factory-class="com.myvendor.connection.ConnFactory"

user-name="mitul"

password="thecleartextpassword">

<config-property>

<config-property-name>Description</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>pooled_transact</config-property-value>

</config-property>

<config-property>

<config-property-name>DatabaseName</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>newDB</config-property-value>

</config-property>

<config-property>

<config-property-name>CreateDatabase</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>create</config-property-value>

</config-property>

. . .

</jndi-binding>

</jndi-bindings>

</cache>

PooledDataSource示例(Derby)

对于在任何事务之外执行的操作,使用PooledDataSource和SimpleDataSource连接。 此示例显示了一个cache.xml文件,该文件是为数据资源newDB的PooledDataSource连接池配置的。 对于此非事务性连接池,登录和阻止超时设置为高于前两个示例中的事务连接池。 连接信息,包括user-name和password,在cache.xml文件中设置,而不是等到连接时间。 密码未加密。

<?xml version="1.0"?>

<cache xmlns="http://geode.apache.org/schema/cache"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://geode.apache.org/schema/cache http://geode.apache.org/schema/cache/cache-1.0.xsd"

version="1.0"

lock-lease="120"

lock-timeout="60"

search-timeout="300">

<region name="root">

<region-attributes scope="distributed-no-ack" data-policy="cached"

initial-capacity="16" load-factor="0.75" concurrency-level="16" statistics-enabled="true">

. . .

</region>

<jndi-bindings>

<jndi-binding

type="PooledDataSource"

jndi-name="newDB1"

init-pool-size="2"

max-pool-size="7"

idle-timeout-seconds="20"

blocking-timeout-seconds="20"

login-timeout-seconds="30"

conn-pooled-datasource-class="org.apache.derby.jdbc.EmbeddedConnectionPoolDataSource"

user-name="mitul"

password="thecleartextpassword">

<config-property>

<config-property-name>Description</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>pooled_transact</config-property-value>

</config-property>

<config-property>

<config-property-name>DatabaseName</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>newDB</config-property-value>

</config-property>

<config-property>

<config-property-name>CreateDatabase</config-property-name>

<config-property-type>java.lang.String</config-property-type>

<config-property-value>create</config-property-value>

</config-property>

. . .

</jndi-binding>

</jndi-bindings>

</cache>

SimpleDataSource连接示例(Derby)

下面的示例显示cache.xml文件中的一个非常基本的配置,用于与数据资源oldDB的SimpleDataSource连接。 您只需要为此连接池配置一些属性,如jndi-name,oldDB1和databaseName,oldDB。 此密码为明文。

简单的数据源连接通常不需要特定于供应商的属性设置。 如果需要,请添加config-property标签,如前面的示例所示。

<?xml version="1.0"?>

<cache xmlns="http://geode.apache.org/schema/cache"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://geode.apache.org/schema/cache http://geode.apache.org/schema/cache/cache-1.0.xsd"

version="1.0"

lock-lease="120"

lock-timeout="60"

search-timeout="300">

<region name="root">

<region-attributes scope="distributed-no-ack" data-policy="cached" initial-capacity="16"

load-factor="0.75" concurrency-level="16" statistics-enabled="true">

. . .

</region-attributes>

</region>

<jndi-bindings>

<jndi-binding type="SimpleDataSource"

jndi-name="oldDB1"

jdbc-driver-class="org.apache.derby.jdbc.EmbeddedDriver"

user-name="mitul"

password="thecleartextpassword"

connection-url="jdbc:derby:newDB;create=true">

. . .

</jndi-binding>

</jndi-bindings>

</cache>

数据加载器的工作原理

默认情况下,区域没有定义数据加载器。 通过在托管区域数据的成员上设置region属性cache-loader,将应用程序定义的加载程序插入任何区域。

在get操作期间,加载器在高速缓存未命中时被调用,除了将值返回给调用线程之外,它还使用新的条目值填充高速缓存。

可以将加载程序配置为从外部数据存储将数据加载到Geode缓存中。 要执行反向操作,将数据从Geode缓存写入外部数据存储,请使用缓存编写器事件处理程序。 请参见实现缓存事件处理程序.

如何安装缓存加载器取决于区域的类型。

分区区域中的数据加载

由于它们可以处理大量数据,因此分区区域支持分区加载。 每个缓存加载器仅加载定义加载器的成员中的数据条目。 如果配置了数据冗余,则仅在成员拥有主副本时才加载数据。 因此,您必须在分区属性local-max-memory不为零的每个成员中安装缓存加载器。

如果依赖于JDBC连接,则每个数据存储都必须与数据源建立连接,如下图所示。 这三个成员需要三个连接。 有关如何配置数据源的信息,请参阅使用JNDI配置数据库连接。

注意: 分区区域通常需要比分布式区域更多的JDBC连接。

分布式区域中的数据加载

在非分区的分布式区域中,一个成员中定义的缓存加载器可供所有已定义区域的成员使用。 加载器通常仅定义在包含该区域的高速缓存的子集中。 当需要加载器时,将调用该区域的所有可用加载器,从最方便的加载器开始,直到加载数据或尝试所有加载器。

在下图中,一个群集的这些成员可以在不同的计算机上运行。 从M1执行对分布区域的加载。

本地区域的数据加载

对于本地区域,缓存加载器仅在定义它的成员中可用。 如果定义了加载程序,则只要在本地缓存中找不到值,就会调用它。

实现数据加载器

要使用数据加载器:

- 实现

org.apache.geode.cache.CacheLoader接口。 - 配置和部署实施。

实现CacheLoader接口

对于get操作,如果键不在缓存中,则为get操作提供服务的线程将调用CacheLoader.load方法。 实现load以返回键的值,除了返回给调用者之外,它还将被放入该区域。

org.apache.geode.cache.CacheLoader继承自Declarable,因此如果你的CacheLoader实现需要用一些参数初始化,那么实现Declarable.initialize方法。 在cache.xml文件或gfshcreate region或alter region命令中指定所需的参数。 不要定义Declarable.init()方法; 它已被弃用。

这是一个示例实现:

public class SimpleCacheLoader implements CacheLoader {

public Object load(LoaderHelper helper) {

String key = (String) helper.getKey();

// Return an entry value created from the key, assuming that

// all keys are of the form "key1", "key2", "keyN"

return "LoadedValue" + key.substring(3);

}

}

如果需要从实现中运行Region API调用,则为它们生成单独的线程。 不要从load方法直接调用Region方法,因为它可能导致缓存加载器阻塞,从而损害集群的性能。

配置和部署

使用以下三种方法之一配置和部署缓存加载器:

选项 1: 如果通过定义cache.xml文件来配置集群,则在启动服务器时通过将缓存加载器添加到类路径来进行部署。

这是cache.xml文件中的一个示例配置,它指定不带参数的加载器:

<region-attributes>

<cache-loader>

<class-name>myLoader</class-name>

</cache-loader>

</region-attributes>

或者,这是cache.xml文件中的一个示例配置,它指定带有参数的加载器:

<cache-loader>

<class-name>com.company.data.DatabaseLoader</class-name>

<parameter name="URL">

<string>jdbc:cloudscape:rmi:MyData</string>

</parameter>

</cache-loader>

要部署JAR文件,请在启动服务器时将缓存加载器JAR文件添加到类路径中。 例如:

gfsh>start server --name=s2 --classpath=/var/data/lib/myLoader.jar

选项 2: 如果在服务器启动时部署JAR文件,请将JAR文件添加到类路径并使用gfsh将配置应用于该区域。

要部署JAR文件,请在启动服务器时将缓存加载器JAR文件添加到类路径中。 例如:

gfsh>start server --name=s2 --classpath=/var/data/lib/myLoader.jar

使用gfsh将CacheLoader实现的配置应用于具有gfsh create region或gfsh alter region的区域。 以下是不带参数的区域创建示例:

gfsh>create region --name=r3 --cache-loader=com.example.appname.myCacheLoader

以下是使用参数创建区域的示例:

gfsh>create region --name=r3 \

--cache-loader=com.example.appname.myCacheLoader{'URL':'jdbc:cloudscape:rmi:MyData'}

以下是更改区域的示例:

gfsh>alter region --name=r3 --cache-loader=com.example.appname.myCacheLoader

选项 3 适用于分区区域: 如果在启动服务器后使用gfsh deploy命令部署JAR文件,请使用gfsh将配置应用于该区域。

创建服务器后,使用gfsh将JAR文件部署到所有服务器。 例如:

gfsh>deploy --jars=/var/data/lib/myLoader.jar

当服务器托管复制区域时,我们通常不使用gfsh deploy命令,详见数据加载器如何工作.

使用gfsh将CacheLoader实现的配置应用于具有gfsh create region或gfsh alter region的区域。 以下是不带参数的区域创建示例:

gfsh>create region --name=r3 --cache-loader=com.example.appname.myCacheLoader

以下是使用参数创建区域的示例:

gfsh>create region --name=r3 \

--cache-loader=com.example.appname.myCacheLoader{'URL':'jdbc:cloudscape:rmi:MyData'}

以下是更改区域的示例:

gfsh>alter region --name=r3 --cache-loader=com.example.appname.myCacheLoader

使用缓存加载器实现服务器或对等

具有嵌入式缓存的服务器和对等体可以仅在有意义的成员中配置缓存加载器。 例如,设计可以将从数据库加载的作业分配给由更多成员托管的区域的一个或两个成员。 当外部源是数据库时,可以这样做以减少连接数。

实现org.apache.geode.cache.CacheLoader接口。 区域创建配置缓存加载器,如下例所示:

RegionFactory<String,Object> rf = cache.createRegionFactory(REPLICATE);

rf.setCacheLoader(new QuoteLoader());

quotes = rf.create("NASDAQ-Quotes");

数据序列化

您在Geode中管理的数据必须序列化和反序列化,以便在进程之间进行存储和传输。 您可以选择多个数据序列化选项。

数据序列化概述

Geode提供除Java序列化之外的序列化选项,为数据存储,传输和语言类型提供更高的性能和更大的灵活性。

Geode PDX 序列化

Geode的便携式数据交换(PDX)是一种跨语言数据格式,可以降低分发和序列化对象的成本。 PDX将数据存储在您可以单独访问的命名字段中,以避免反序列化整个数据对象的成本。 PDX还允许您混合已添加或删除字段的对象版本。

Geode 数据序列化 (DataSerializable and DataSerializer)

Geode的

DataSerializable接口为您提供了对象的快速序列化。标准的 Java 序列化

您可以对仅在Java应用程序之间分发的数据使用标准Java序列化。 如果在非Java客户端和Java服务器之间分发数据,则需要执行其他编程以获取各种类格式之间的数据。

数据序列化概述

Geode提供除Java序列化之外的序列化选项,为数据存储,传输和语言类型提供更高的性能和更大的灵活性。

Geode移出本地缓存的所有数据都必须是可序列化的。 但是,您不一定需要实现java.io.Serializable,因为Geode中提供了其他序列化选项。 必须可序列化的区域数据属于以下类别:

- 分区区域

- 分布式区域

- 持久存储或溢出到磁盘的区域

- 客户端/服务器安装中的服务器或客户端区域

- 配置了网关发件人的区域,用于在多站点安装中分发事件

- 从远程缓存接收事件的区域

- 提供函数参数和结果的区域

注意: 如果使用HTTP会话管理模块存储对象,则这些对象必须是可序列化的,因为它们在被序列化之前 存储在该地区。

为了最大限度地降低序列化和反序列化的成本,Geode尽可能避免更改数据格式。 这意味着您的数据可能以序列化或反序列化的形式存储在缓存中,具体取决于您使用它的方式。 例如,如果服务器仅充当客户端之间数据分发的存储位置,则将数据保留为序列化形式,准备传输给请求它的客户端是有意义的。 分区区域数据最初始终以序列化形式存储。

数据序列化选项

使用Geode,您可以选择自动序列化域对象或使用Geode的一个接口实现序列化。 启用自动序列化意味着域对象被序列化和反序列化,而无需对这些对象进行任何代码更改。 这种自动序列化是通过使用名为ReflectionBasedAutoSerializer的自定义PdxSerializer注册域对象来执行的,该自定义PdxSerializer使用Java反射来推断要序列化的字段。

如果autoserialization不能满足您的需求,您可以通过实现Geode接口之一,PdxSerializable或DataSerializable来序列化您的对象。 您可以使用这些接口替换任何标准Java数据序列化以获得更好的性能。 如果你不能或不想修改你的域类,每个接口都有一个备用的序列化器类,PdxSerializer和DataSerializer。 要使用这些,请创建自定义序列化程序类,然后将其与Geode缓存配置中的域类相关联。

Geode数据序列化比PDX序列化快约25%,但使用PDX序列化将帮助您避免执行反序列化的更高成本。

| 性能 | Geode Data Serializable | Geode PDX Serializable |

|---|---|---|

| Implements Java Serializable. | X | |

| 处理多个版本的应用程序域对象,通过添加或减少字段来提供不同的版本. | X | |

| 提供序列化数据的单字段访问,无需完全反序列化 - 也支持OQL查询. | X | |

| Geode自动移植到其他语言 | X | |

| Works with .NET clients. | X | X |

| Works with C++ clients. | X | X |

| Works with Geode delta propagation. | X | X (See note below.) |

表 1. 序列化选项:功能比较

注意: 默认情况下,您可以将Geode delta传播与PDX序列化一起使用。 但是,如果已将Geode属性read-serialized设置为“true”,则delta传播将不起作用。 在反序列化方面,要应用更改增量传播,需要域类实例和fromDelta方法。 如果你将read-serialized设置为true,那么你将收到一个PdxInstance而不是一个域类实例,而PdxInstance没有delta传播所需的fromDelta方法。

Geode序列化(PDX或数据可序列化)和Java序列化之间的差异

Geode序列化(PDX序列化或数据序列化)不支持循环对象图,而Java序列化则支持循环对象图。 在Geode序列化中,如果在对象图中多次引用同一对象,则为每个引用序列化对象,并且反序列化生成对象的多个副本。 相比之下,在这种情况下,Java序列化将对象序列化一次,并且在反序列化对象时,它会生成具有多个引用的对象的一个实例。

Geode PDX序列化

Geode的便携式数据交换(PDX)是一种跨语言数据格式,可以降低分发和序列化对象的成本。 PDX将数据存储在您可以单独访问的命名字段中,以避免反序列化整个数据对象的成本。 PDX还允许您混合已添加或删除字段的对象版本。

Geode PDX序列化功能

Geode PDX序列化在功能方面具有多项优势。

使用PDX序列化的高级步骤

要使用PDX序列化,您可以配置和使用Geode基于反射的自动化程序,也可以使用PDX接口和类对对象的序列化进行编程。

使用基于自动反射的PDX序列化

您可以将缓存配置为自动序列化和反序列化域对象,而无需向其添加任何额外代码。

使用PdxSerializer序列化您的域对象

对于您不能或不想修改的域对象,请使用

PdxSerializer类来序列化和反序列化对象的字段。 您对整个缓存使用一个PdxSerializer实现,为您以这种方式处理的所有域对象编程。在域对象中实现PdxSerializable

对于可以修改源的域对象,在对象中实现

PdxSerializable接口,并使用其方法序列化和反序列化对象的字段。编写应用程序以使用PdxInstances